常用的 Docker 命令

Docker 常用命令大全 Docker 基础命令 命令 说明 示例 docker version 查看 Docker 客户端与服务端版本 docker version docker info 显示 Docker 系统信息 ...

Docker 常用命令大全 Docker 基础命令 命令 说明 示例 docker version 查看 Docker 客户端与服务端版本 docker version docker info 显示 Docker 系统信息 ...

本文转载自博客园 行无际《一文学会在Markdown中编辑数学符号与公式》 在用Markdown写博客时会涉及到数学符号与公式的编辑,下面进行汇总。随手记录,方便你我他。 行内公式:将公式插入到本行内 $0.98^{365} \approx 0.0006$ 我的365天:$0.98^{365} \approx 0.0006$ 单独的公式块:将公式插入到新的一行内,...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! Transformer:抛弃顺序计算的注意力革命 Transformer模型自2017年横空出世,迅速成为自然语言处理(NLP)乃至整个AI领域的基石。它的出现,标志着机器对语言理解方式的一次根本性转变。 在此之前,循环神经网络(RNN)及其变体(如LSTM、GRU)虽然能处理序列数据,但却...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! 循环神经网络 RNN(Recurrent Neural Network) 之前的卷积神经网络适合处理图片信息,那文字信息怎么办呢?首先要明白,对于计算机,或者说神经网络来说,文字都是要转换为数字之后再进行处理的。那么我们要面对的第一个问题就是:如何将文字转换为数字 有一种简单粗暴的方法:每一...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! 矩阵表示、卷积与 CNN:从“密集连接”到“局部共享”的直观演绎 本篇目标: 一、回到矩阵表示:把复杂式子变得简洁且可并行 当网络刚开始只有少量节点时,我们可以直接用元素级公式写出每个神经元的输出。但随着层数和每层节点数增长,逐个写式子既繁琐又不利于数学推导与实现。用矩阵把这些运算...

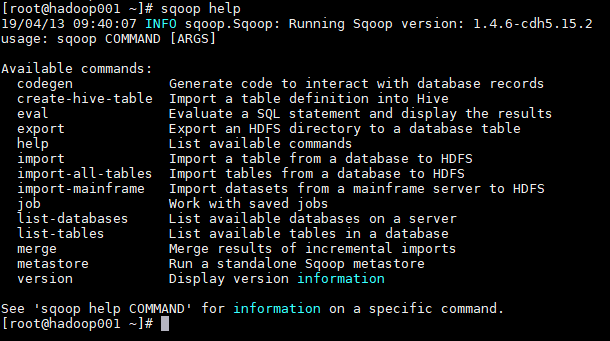

一、Sqoop 基本命令 1. 查看所有命令 ```plain text sqoop help  ### 2. 查看某条命令的具体使用方法 ``...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! 🧠 神经网络训练中的问题与解决方法 ——从过拟合到正则化的全面解析 “训练一个模型不难,难的是让它在没见过的数据上依然聪明。” 🌱 一、从成功到困惑:模型为何“记住”了数据? 假设我们用数千张图片训练了一个神经网络,训练损失迅速下降,准确率高得惊人。 然而,当我们在新图片上测试...

一、Sqoop 简介 Sqoop 是一个常用的数据迁移工具,主要用于在不同存储系统之间实现数据的导入与导出: 导入数据:从 MySQL,Oracle 等关系型数据库中导入数据到 HDFS、Hive、HBase 等分布式文件存储系统中; 导出数据:从 分布式文件系统中导出数据到关系数据库中。 其原理是将执行命令转化成 MapReduce 作业来实现数据的迁移,如下图: ...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! 如何计算神经网络的参数:从损失函数到梯度下降与反向传播 摘要 这篇文章用直观比喻与必要数学并重的方式,讲清楚三件事: 为什么需要“损失函数”来量化预测与真实之间的差距 如何用“梯度下降”把参数一步步调到更好 反向传播如何高效地计算大规...

全文总结于 Bilibili UP 主飞天闪客的一小时到 Transformer 系列视频! 从函数到神经网络:技术演进与核心关联解析 摘要 神经网络是当前人工智能领域的核心技术之一,但其本质是对“函数”这一基础数学概念的复杂延伸与组合。从早期人工智能符号主义(追求精确函数)到现代联结主义(追求函数近似),技术路线的转变揭示了神经网络的本质:通过层级嵌套和参数优化,构造一个能够逼近任...