分布式系统设计《中文版》

《分布式系统模式》(Patterns of Distributed Systems)是 Unmesh Joshi 编写的一系列关于分布式系统实现的文章。这个系列的文章采用模式的格式,介绍了像 Kafka、Zookeeper 这种分布式系统在实现过程采用的通用模式,是学习分布式系统实现的基础。

目录

概述

模式

- 一致性内核(Consistent Core)

- 固定分区(Fixed Partitions)

- 追随者读取(Follower Reads)

- 世代时钟(Generation Clock)

- Gossip 传播(Gossip Dissemination)

- 心跳(HeartBeat)

- 高水位标记(High-Water Mark)

- 混合时钟(Hybrid Clock)

- 幂等接收者(Idempotent Receiver)

- 键值与值(Key And Value)

- Lamport 时钟(Lamport Clock)

- 领导者和追随者(Leader and Followers)

- 租约(Lease)

- 低水位标记(Low-Water Mark)

- Paxos

- Quorum

- 复制日志(Replicated Log)

- 批量请求(Request Batch)

- 请求管道(Request Pipeline)

- 分段日志(Segmented Log)

- 单一 Socket 通道(Single Socket Channel)

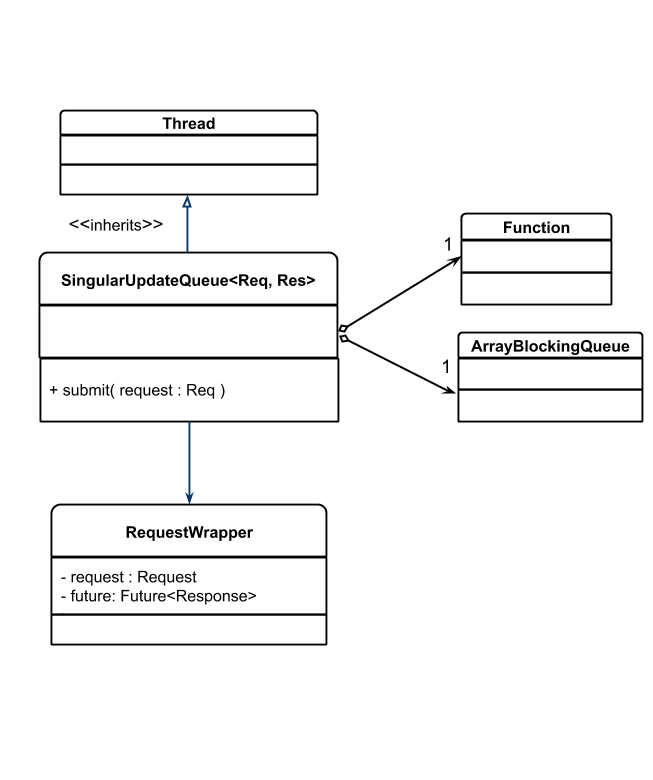

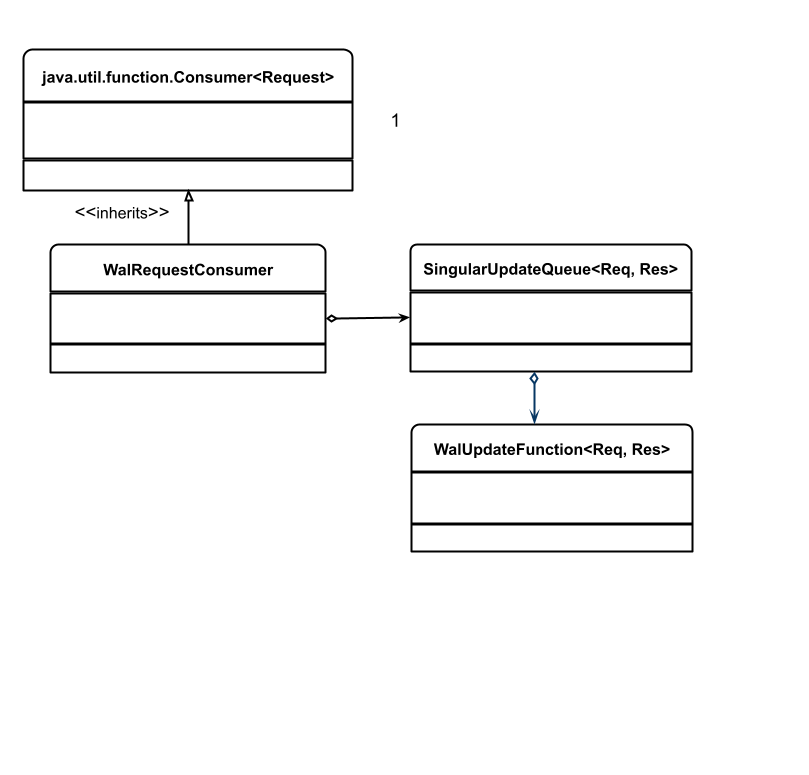

- 单一更新队列(Singular Update Queue)

- 状态监控(State Watch)

- 两阶段提交(Two Phase Commit)

- 版本向量(Version Vector)

- 有版本的值(Versioned Values)

- 预写日志(Write-Ahead Log)

术语表

| 英文 | 翻译 |

|---|---|

| durability | 持久性 |

| Write-Ahead Log | 预写日志 |

| append | 追加 |

| hash | 哈希 |

| replicate | 复制 |

| failure | 失效 |

| partition | 分区 |

| HeartBeat | 心跳 |

| Quorum | Quorum |

| Leader | 领导者 |

| Follower | 追随者 |

| High Water Mark | 高水位标记 |

| Low Water Mark | 低水位标记 |

| entry | 条目 |

| propagate | 传播 |

| disconnect | 失联、断开连接 |

| Generation Clock | 世代时钟 |

| group membership | 分组成员 |

| partitions | 分区 |

| liveness | 活跃情况 |

| round trip | 往返 |

| in-flight | 在途 |

| time to live | 存活时间 |

| head of line blocking | 队首阻塞 |

| coordinator | 协调者 |

| lag | 滞后 |

| fanout | 扇出 |

| incoming | 传入 |

| CommitIndex | 提交索引 |

| candidate | 候选者 |

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/

分布式系统给软件开发带来了一些特殊的挑战,要求数据有多个副本,且彼此间要保持同步。然而,我们不能保证所有工作节点都能可靠地工作,网络延迟会轻易地造成不一致。尽管如此,许多组织依然要依赖一系列核心的分布式软件来处理数据存储、消息通信、系统管理以及计算能力。这些系统面临着共同的问题,可以采用类似的方案解决。本文将这些方案进行分类,并进一步提炼成模式。通过模式,我们可以认识到如何更好的理解、交流和传授分布式系统设计。

2020.6.17

Unmesh Joshi

Unmesh Joshi 是 ThoughtWorks 的总监级咨询师。他是一个软件架构的爱好者,相信在今天理解分布式系统的原则,同过去十年里理解 Web 架构或面向对象编程一样至关重要。

这个系列在讨论什么

在过去的几个月里,我在 ThoughtWorks 内部组织了许多分布式系统的工作坊。在组织这些工作坊的过程中,我们面临的一个严峻挑战就是,如何将分布式系统的理论映射到诸如 Kafka 或Cassandra 这样的开源代码库上,同时,还要保持讨论足够通用,覆盖尽可能广泛的解决方案。模式的概念为此提供了一个不错的出路。

从模式的本质上说,其结构让我们可以专注在一个特定的问题上,这就很容易说清楚,为什么需要一个特定的解决方案。解决方案的描述让我们有了一个代码结构,对于展示一个实际的解决方案而言,它足够具体,对于涵盖广泛的变体而言,它又足够通用。模式技术还可以将不同的模式联系在一起,构建出一个完整的系统。由此,便有了一个讨论分布式系统实现非常好的词汇表。

下面就是从主流开源分布式系统中观察到的第一组模式。希望这组模式对所有的程序员都有用。

分布式系统:一个实现的视角

今天的企业架构充满了各种天生就分布的平台和框架。如果从今天典型的企业应用架构选取典型平台和框架组成列表,我们可能会得到类似于下面这样一个列表:

| 平台/框架的类型 | 样例 |

|---|---|

| 数据库 | Cassandra、HBase、Riak |

| 消息队列 | Kafka、Pulsar |

| 基础设施 | Kubernetes、Mesos、Zookeeper、etcd、Consul |

| 内存数据/计算网格 | Hazelcast、Pivotal、Gemfire |

| 有状态微服务 | Akka Actors、Axon |

| 文件系统 | HDFS、Ceph |

所有这些天生都是“分布式的”。对一个系统而言,分布式意味着什么呢?它包含两个方面:

- 这个系统运行在多个服务器上。集群中的服务器数量差异极大,少则两三台,多则数千台。

- 这个系统管理着数据。因此,其本质上是一个“有状态”的系统。

当多台服务器参与到存储数据中,总有一些地方会出错。上述所有提及的系统都需要解决这些问题。在这些系统的实现中,解决这些问题时总有一些类似的解决方案。以通用的形式理解这些解决方案,有助于在更大的范围内理解这些系统的实现,也可以当做构建新系统的指导原则。

好,进入模式。

模式

模式,这是 Christopher Alexander 引入的一个概念,现在在软件设计社区得到了广泛地接受,用以记录在构建软件系统所用的各种设计构造。模式提供一种“从问题到解决方案”的结构化方式,它可以在许多地方见到,并且得到了证明。使用模式的一种有意思的方式是,采用模式序列或模式语言的形式,将多个模式联系在一起,这为实现“整个”或完整的系统提供了指导方向。将分布式系统视为一系列模式是一种有价值的做法,可以获得关于其实现更多的洞见。

问题及可复用的解决方案

当数据要存储在多台服务器上时,有很多地方可能会出错。

进程崩溃

进程随时都会崩溃,无论是硬件故障,还是软件故障。进程崩溃的方式有许多种:

- 系统管理员进行常规维护时,进程可能会挂掉

- 因为磁盘已满,异常未能正确处理,做一些文件 IO 时进程可能被杀掉

- 在云环境中,甚至更加诡异,一些无关因素都会让服务器宕机

如果进程负责存储数据,底线是其设计要对存储在服务器上的数据给予一定的持久性(durability)保证。即便进程突然崩溃,所有已经通知用户成功存储的数据也要得以保障。依赖于其存储模式,不同的存储引擎有不同的的存储结构,从简单的哈希表到复杂的图存储。因为将数据写入磁盘是最耗时的过程,可能不是每个对存储的插入或更新都来得及写入到磁盘中。因此,大多数数据库都有内存存储结构,其只完成周期性的磁盘写入。这就增加了“进程突然崩溃丢失所有数据”的风险。

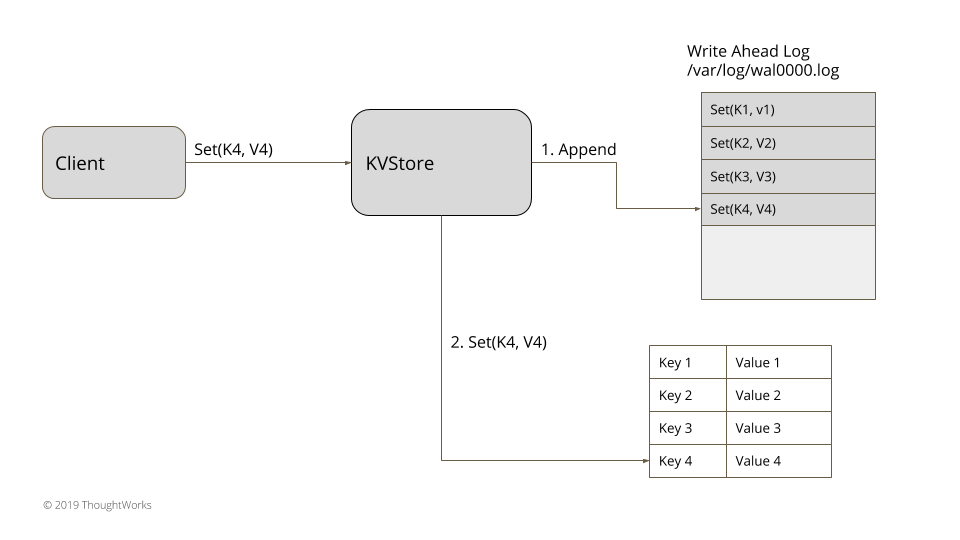

有一种叫预写日志(Write-Ahead Log,简称 WAL)的技术就是用来对付这种情况的。服务器存储将每个状态改变当做一个命令记录在硬盘上的一个只追加(append-only)的文件上。在文件上附加是一个非常快的操作,因此,它几乎对性能完全没有影响。这样一个可以顺序追加的日志可以存储每次更新。在服务器启动时,日志可以回放,以重建内存状态。

这就保证了持久性。即便服务器突然崩溃再重启,数据也不会丢失。但是,客户端在服务器恢复之前是不能获取或存储数据的。因此,在服务器失效时,我们缺乏了可用性。

一个显而易见的解决方案是将数据存储在多台服务器上。因此,我们可以将 WAL 复制到多台服务器上。

一旦有了多台服务器,就需要考虑更多的失效场景了。

网络延迟

在 TCP/IP 协议栈中,跨网络传输消息的延迟并没有一个上限。由于网络负载,这个值差异会很大。比如,由于触发了一个大数据的任务,一个 1Gbps 的网络也可能会被吞噬,网络缓冲被填满,一些消息到达服务器的延迟可能会变得任意长。

在一个典型的数据中心里,服务器并排放在机架上,多个机架通过顶端的机架交换机连接在一起。可能还会有一棵交换机树,将数据中心的一部分同另外的部分连接在一起。在某些情况下,一组服务器可以彼此通信,却与另一组服务器断开连接。这种情况称为网络分区。服务器通过网络进行通信时,一个基本的问题就是,知道一个特定的服务器何时失效。

这里有两个问题要解决。

- 一个特定的服务器不能为了知晓其它服务器是否已崩溃而无限期地等待。

- 不应该出现两组服务器,彼此都认为对方已经失效,因此,继续为不同的客户端提供服务,这种情况称为脑裂。

要解决第一个问题,每个服务器都要以固定的间隔像其它服务器发送一个心跳(HeartBeat)消息。如果心跳丢失,那台服务器就会被认为是崩溃了。心跳间隔要足够小,确保检测到服务器失效并不需要花太长的时间。正如我们下面将要看到的那样,在最糟糕的情况下,服务器可能已经重新启动,集群作为一个整体依然认为这台服务器还在失效中,这样才能确保提供给客户端的服务不会就此中断。

第二个问题是脑裂。一旦产生脑裂,两组服务器就会独立接受更新,不同的客户端就会读写不同的数据,脑裂即便解决了,这些冲突也不可能自动得到解决。

要解决脑裂问题,必须确保两组失联的服务器不能独立地前进。为了确保这一点,服务器采取的每个动作,只有经过大多数服务器的确认之后,才能认为是成功的。如果服务器无法获得多数确认,就不能提供必要的服务。某些客户端可能无法获得服务,但服务器集群总能保持一致的状态。占多数的服务器的数量称为 Quorum。如何确定 Quorum 呢?这取决于集群所容忍的失效数量。如果有一个 5 个节点的集群,Quorum 就应该是 3。总的来说,如果想容忍 f 个失效,集群的规模就应该是 2f + 1。

Quorum 保证了我们拥有足够的数据副本,以拯救一些服务器的失效。但这不足以给客户端以强一致性保证。比如,一个客户在 Quorum 上发起了一个写操作,但该操作只在一台服务器上成功了。Quorum 上其它服务器依旧是原有的值。当客户端从这个 Quorum 上读取数据时,如果有最新值的服务器可用,它得到的就可能是最新的值。但是,如果客户端开始读取这个值时,有最新值的服务器不可用,它得到的就可能是一个原有的值了。为了避免这种情况,就需要有人追踪是否 Quorum 对于特定的操作达成了一致,只有那些在所有服务器上都可用的值才会发送给客户端。在这种场景下,会使用领导者和追随者(Leader and Followers)。领导者控制和协调在追随者上的复制。由领导者决定什么样的变化对于客户端是可见的。高水位标记(High Water Mark)用于追踪在 WAL 上的项是否已经成功复制到 Quorum 的追随者上。所有达到高水位标记的条目就会对客户端可见。领导者还会将高水位标记传播给追随者。因此,当领导者出现失效时,某个追随者就会成为新的领导者,所以,从客户端的角度看,是不会出现不一致的。

进程暂停

但这并非全部,即便有了 Quorum、领导者以及追随者,还有一个诡异的问题需要解决。领导者进程可能会随意地暂停。进程的暂停原因有很多。对于支持垃圾回收的语言来说,可能存在长时间的垃圾回收暂停。如果领导者有一次长时间的垃圾回收暂停,追随者就可能会失联,领导者在暂停结束之后,会不断地给追随者发消息。与此同时,因为追随者无法收到来自领导者的心跳,它们可能会重新选出一个领导者,以便接收来自客户端的更新。如果原有领导者的请求还是正常处理,它们可能会改写掉一些更新。因此,需要有一个机制检测请求是否是来自过期的领导者。世代时钟(Generation Clock)就是用于标记和检测请求是否来自原有领导者的一种方式。世代,就是一个单调递增的数字。

不同步的时钟和定序问题

检测消息是来自原有的领导者还是新的领导者,这个问题是一个维护消息顺序的问题。一种显而易见的解决方案是,采用系统时间戳为一组消息定序,但是,我们不能这么做。主要原因在于,跨服务器使用系统时钟是无法保证同步的。计算机时钟的时间是由石英晶体管理,并依据晶体震荡来测量时间。

这种机制非常容易出错,因为晶体震荡可能会快,也可能会慢,因此,不同的服务器会产生不同的时间。跨服务器同步时钟,可以使用一种称为 NTP 的服务。这个服务周期性地去查看一组全局的时间服务器,然后,据此调整计算时钟。

因为这种情况出现在网络通信上,正如我们前面讨论过的那样,网络延迟可能会有很大差异,由于网络原因,时钟同步可能会造成延迟。这就会造成服务器时钟彼此偏移,经过 NTP 同步之后,甚至会出现时间倒退。因为这些计算机时钟存在的问题,时间通常是不能用于对事件定序。取而代之的是,可以使用一种简单的技术,称为 Lamport 时间戳。世代时钟就是其中一种。

综合运用——一个分布式系统示例

理解这些模式有什么用呢?接下来,我们就从头构建一个完整的系统,看看这些理解会怎样帮助我们。下面我们以一个共识系统为例。分布式共识,是分布式系统实现的一个特例,它给予了我们强一致性的保证。在常见的企业级系统中,这方面的典型例子是,Zookeeper、etcd 和 Consul。它们实现了诸如 zab 和 Raft 之类的共识算法,提供了复制和强一致性。还有其它一些流行的算法实现共识机制,比如Paxos,Google Chubby 把这种算法用在了锁服务、视图戳复制和虚拟同步(virtual-synchrony)上。简单来说,共识就是指,一组服务器就存储数据达成一致,以决定哪个数据要存储起来,什么时候数据对于客户端可见。

实现共识的模式序列

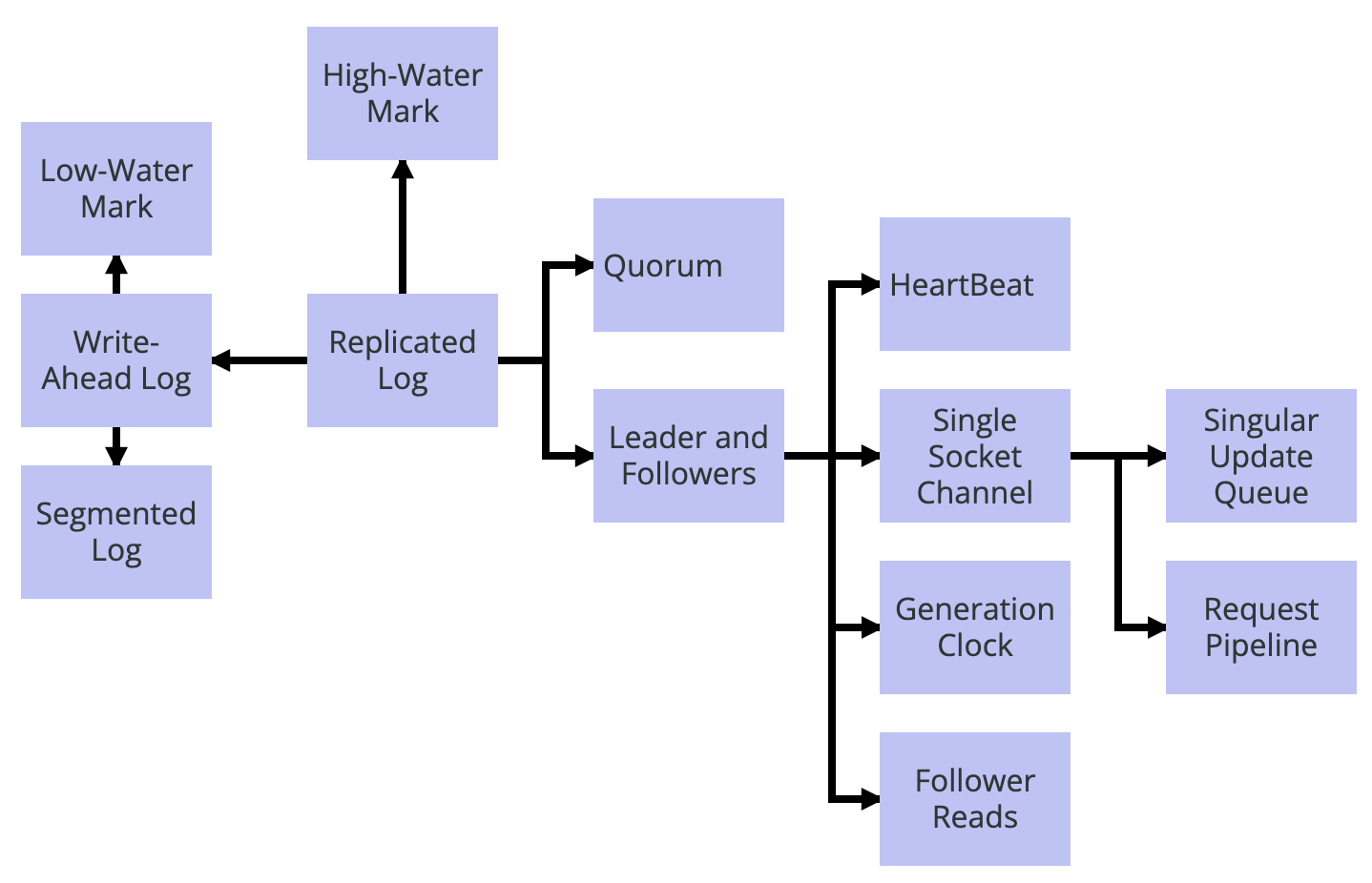

共识实现使用状态机复制(state machine replication),以达到对于失效的容忍。在状态机复制的过程中,类似于键值存储这样的存储服务是在所有服务器上进行复制,用户输入是在每个服务器上以相同的顺序执行。做到这一点,一个关键的实现技术就是在所有服务器上复制预写日志(Write-Ahead Log),这样就有了可复制的 WAL。

我们按照下面的方式可以将模式放在一起去实现可复制的 WAL。

为了提供持久性的保证,要使用预写日志(Write-Ahead Log)。使用分段日志(Segmented Log)可以将预写日志分成多个段。这么有助于实现日志的清理,通常这会采用低水位标记(Low-Water Mark)进行处理。通过将预写日志复制到多个服务器上,失效容忍性就得到了保障。在服务器间复制由领导者和追随者(Leader and Followers)保障。Quorum 用于更新高水位标记(High Water Mark),以决定哪些值对客户端可见。所有的请求都严格按照顺序进行处理,这可以通过单一更新队列(Singular Update Queue)实现。领导者发送请求给追随者时,使用单一 Socket 通道(Single Socket Channel)就可以保证顺序。要在单一 Socket 通道上优化吞吐和延迟,可以使用请求管道(Request Pipeline)。追随者通过接受来自领导者的心跳(HeartBeat)以确定领导者的可用性。如果领导者因为网络分区的原因,临时在集群中失联,可以使用世代时钟(Generation Clock)检测出来。如果只由领导者服务所有的请求,它就可能会过载。当客户端是只读的,而且能够容忍读取到陈旧的值,追随者服务器也可以提供服务。追随者读取(Follower Reads)就允许由追随者服务器对读取请求提供服务。

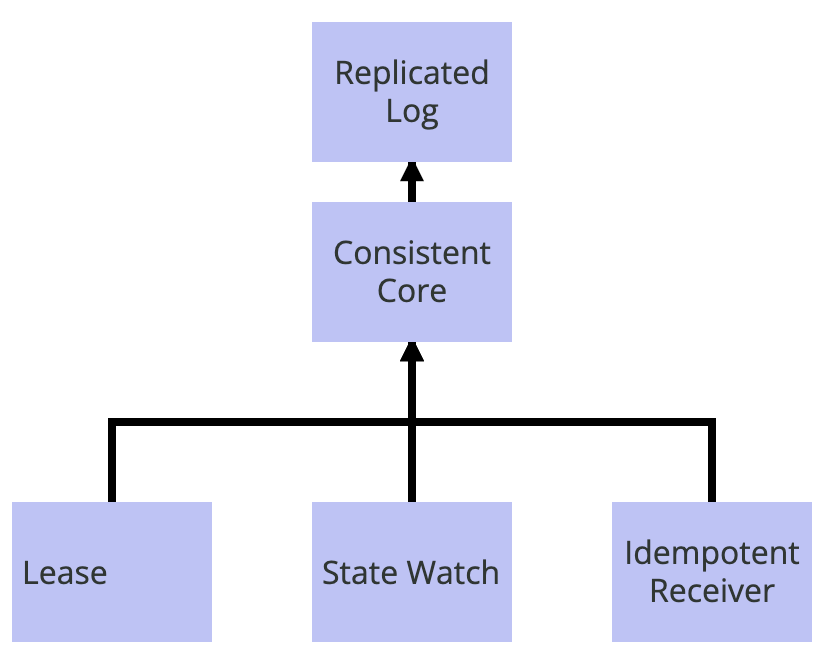

Kubernetes 或 Kafka 的控制平面

像 Kubernetes 或 Kafka 这样产品的架构是围绕着一个强一致的元数据存储构建起来的。我们可以把它理解成一个模式序列。一致性内核(Consistent Core)用作一个强一致、可容错的元数据存储。租约(Lease)用于实现集群节点的分组成员和失效检测。当集群节点失效或更新其元数据时,其它集群节点可以通过状态监控(State Watch)获得通知。在网络失效重试的情况下,一致性内核(Consistent Core)的实现可以用[幂等接收者(Idempotent Receiver)]忽略集群节点发送的重复请求。一致性内核(Consistent Core)可以采用可复制的 WAL,上一节已经描述过这个模式序列了。

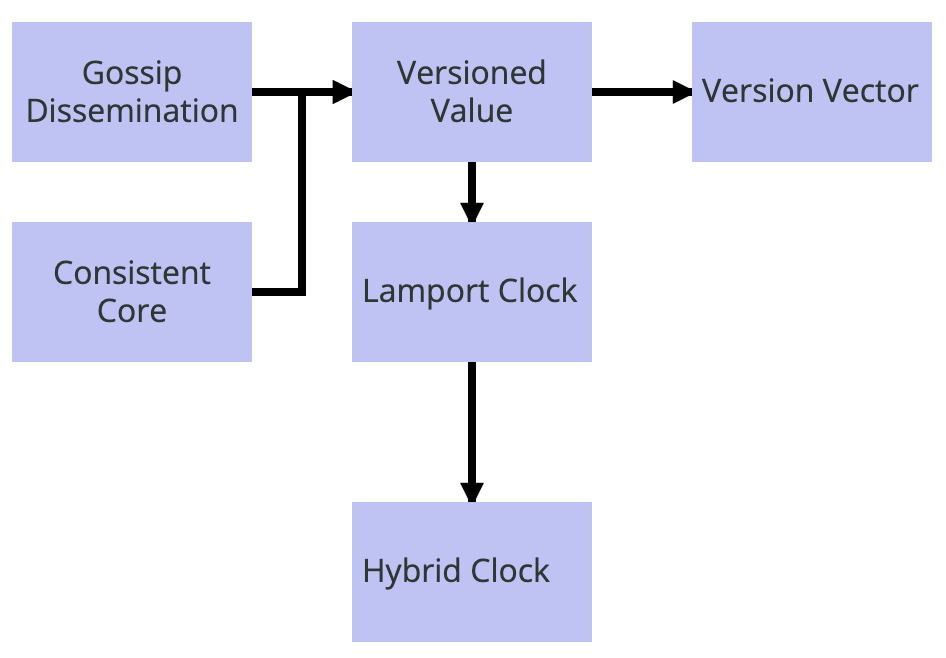

逻辑时间戳的使用

各种类型逻辑时间戳的使用也可以看作是一个模式序列。各种产品可以使用 Gossip 传播(Gossip Dissemination)或一致性内核(Consistent Core)处理群集节点的分组成员和失效检测。数据存储使用有版本的值(Versioned Value)就能够确定哪个值是最新的。如果有单台服务器负责更新值,或是使用了领导者和追随者(Leader and Followers),可以使用 Lamport 时钟(Lamport Clock)当做有版本的值(Versioned Value) 中的版本。当时间戳需要从一天中时间中推导出来时,可以使用混合时钟(Hybrid Clock),替代简单的 Lamport 时钟(Lamport Clock)。如果允许多台服务器处理客户端请求,更新同样的值,可以使用版本向量(Version Vector),这样能够检测出在不同集群节点上的并发写入。

这样,以通用的形式理解问题以及其可复用的解决方案,有助于理解整个系统的构造块。

下一步

分布式系统是一个巨大的话题。这里涵盖的这套模式只是其中的一小部分,它们覆盖了不同的主题,展示了一个模式能够如何帮助我们理解和设计分布式问题。我将持续在添加更多的模式,包括分布式系统中解决的下列主题:

- 成员分组以及失效检测

- 分区

- 复制与一致性

- 存储

- 处理

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/consistent-core.html

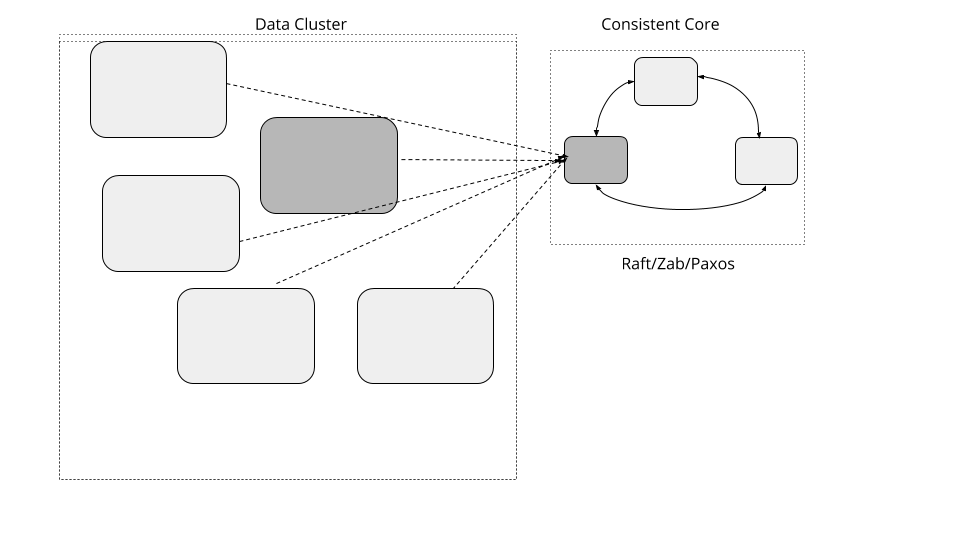

维护一个较小的内核,为大规模数据集群提供更强的一致性,这样,可以在无需实现基于 Quorum 算法的前提下协调服务器行为。

2021.1.5

问题

集群需要处理大规模的数据,就需要越来越多的服务器。对于服务器集群而言,有一些通用性的需求,比如,选择某个特定的服务器成为某个任务的主节点、管理分组成员信息、将数据分区映射到服务器上等等。这些需求都需要强一致性的保证,也就是说,要有线性一致性。实现本身还要有对失效的容忍。一种常见的方式是,使用一种基于 Quorum 且支持失效容忍的一致性算法。但是,基于 Quorum 的系统,其吞吐量会随着集群规模的变大而降低。

解决方案

实现一个三五个节点的小集群,提供线性一致性的保证,同时支持失效容忍[1]。一个单独数据集群可以使用小的一致性集群管理元数据,采用类似于租约(Lease) 之类的原语在集群范围内进行决策。这样一来,数据集群就可以增长到很大的规模,但对于某些需要强一致性保证的动作,可以使用比较小的元数据集群。

一个典型一致性内核接口应该是下面这个样子:

1

2

3

4

5

6

7

8

9

public interface ConsistentCore {

CompletableFuture put(String key, String value);

List<String> get(String keyPrefix);

CompletableFuture registerLease(String name, long ttl);

void refreshLease(String name);

void watch(String name, Consumer<WatchEvent> watchCallback);

}

以最低的标准看,一致性内核提供了一个简单的键值存储机制,用于存储元数据。

元数据存储

存储可以用诸如 Raft 之类的共识算法实现。它是可复制的预写日志的一个样例实现,其中的复制由领导者和追随者(Leader and Followers) 进行处理,使用 Quorum 的话,可以使用高水位标记(High-Water Mark)追踪成功的复制。

支持层级结构的存储

一致性内核通常用于存储这样的数据,比如,分组成员、跨服务器的任务分布。一种常见的使用模式是,通过前缀将元数据的类型做一个分类,比如,对于分组成员信息,键值可以存成类似于 /servers/1、servers/2 等等。对于任务分配给哪些服务器,键值可以是 /tasks/task1、/tasks/task2。通常来说,要读取这些数据,所有的键值上都要带上特定的前缀。比如,要读取集群中的所有服务器信息,就要读取所有与以 /servers 为前缀的键值。

下面是一个示例的用法:

服务器只要创建一个属于自己的有 /servers 前缀的键值,就可以将自身注册到一致性内核中。

```plain text client1.setValue(“/servers/1”, “{address:192.168.199.10, port:8000}”); client2.setValue(“/servers/2”, “{address:192.168.199.11, port:8000}”); client3.setValue(“/servers/3”, “{address:192.168.199.12, port:8000}”);

1

2

3

4

5

6

7

8

客户端只要读取以 /servers 为前缀的键值,就可以获取所有集群中的服务器信息,像下面这样:

```plain text

assertEquals(client1.getValue("/servers"), Arrays.asList(

"{address:192.168.199.12, port:8000}",

"{address:192.168.199.11, port:8000}",

"{address:192.168.199.10, port:8000}"));

因为数据存储的层次结构属性,像 zookeeper、chubby 提供了类似于文件系统的接口,其中,用户可以创建目录和文件,或是节点,有父子节点概念的那种。etcd3 有扁平的键值空间,这样它就有能力获取更大范围的键值。

处理客户端交互

一致性内核功能的一个关键需求是,客户端如何与内核进行交互。下面是客户端与一致性内核协同工作的关键方面。

找到领导者

所有的操作都要在领导者上执行,这是至关重要的,因此,客户端程序库需要先找到领导者服务器。要做到这一点,有两种可能的方式。

- 一致性内核的追随者服务器知道当前的领导者,因此,如果客户端连接追随者,它会返回 领导者的地址。客户端可以直接连接应答中给出的领导者。值得注意的是,客户端尝试连接时,服务器可能正处于领导者选举过程中。在这种情况下,服务器无法返回领导者地址,客户端需要等待片刻,再尝试连接另外的服务器。

- 服务器实现转发机制,将所有的客户端请求转发给领导者。这样就允许客户端连接任意的服务器。同样,如果服务器处于领导者 选举过程中,客户端需要不断重试,直到领导者选举成功,一个合法的领导者获得确认。 类似于 zookeeper 和 etcd 这样的产品都实现了这种方式,它们允许追随者服务器处理只读请求,以免领导者面对大量客户端的只读请求时出现瓶颈。这就降低了客户端基于请求类型去连接领导者或追随者的复杂性。

一个找到领导者的简单机制是,尝试连接每一台服务器,尝试发送一个请求,如果服务器不是领导者,它给出的应答就是一个重定向的应答。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

private void establishConnectionToLeader(List<InetAddressAndPort> servers) {

for (InetAddressAndPort server : servers) {

try {

SingleSocketChannel socketChannel = new SingleSocketChannel(server, 10);

logger.info("Trying to connect to " + server);

RequestOrResponse response = sendConnectRequest(socketChannel);

if (isRedirectResponse(response)) {

redirectToLeader(response);

break;

} else if (isLookingForLeader(response)) {

logger.info("Server is looking for leader. Trying next server");

continue;

} else {

//we know the leader

logger.info("Found leader. Establishing a new connection.");

newPipelinedConnection(server);

break;

}

} catch (IOException e) {

logger.info("Unable to connect to " + server);

//try next server

}

}

}

private boolean isLookingForLeader(RequestOrResponse requestOrResponse) {

return requestOrResponse.getRequestId() == RequestId.LookingForLeader.getId();

}

private void redirectToLeader(RequestOrResponse response) {

RedirectToLeaderResponse redirectResponse = deserialize(response);

new PipelinedConnection(redirectResponse.leaderAddress);

logger.info("Connected to the new leader "

+ redirectResponse.leaderServerId

+ " " + redirectResponse.leaderAddress

+ ". Checking connection");

}

private boolean isRedirectResponse(RequestOrResponse requestOrResponse) {

return requestOrResponse.getRequestId() == RequestId.RedirectToLeader.getId();

}

仅仅建立 TCP 连接还不够,我们还需要知道服务器能否处理我们的请求。因此,客户端会给服务器发送一个特殊的连接请求,服务器需要响应,它是可以处理请求,还是要重定向到领导者服务器上。

1

2

3

4

5

6

7

8

9

private RequestOrResponse sendConnectRequest(SingleSocketChannel socketChannel) throws IOException {

RequestOrResponse request = new RequestOrResponse(RequestId.ConnectRequest.getId(), "CONNECT", 0);

try {

return socketChannel.blockingSend(request);

} catch (IOException e) {

resetConnectionToLeader();

throw e;

}

}

如果既有的领导者失效了,同样的技术将用于识别集群中新选出的领导者。

一旦连接成功,客户端将同领导者服务器间维持一个单一 Socket 通道(Single Socket Channel)。

处理重复请求

在失效的场景下,客户端可以重新连接新的 领导者,重新发送请求。但是,如果这些请求在失效的领导者之前已经处理过了,这就有可能产生重复。因此,至关重要的一点是,服务器需要有一种机制,忽略重复的请求。幂等接收者(Idempotent Receiver)模式就是用来实现重复检测的。

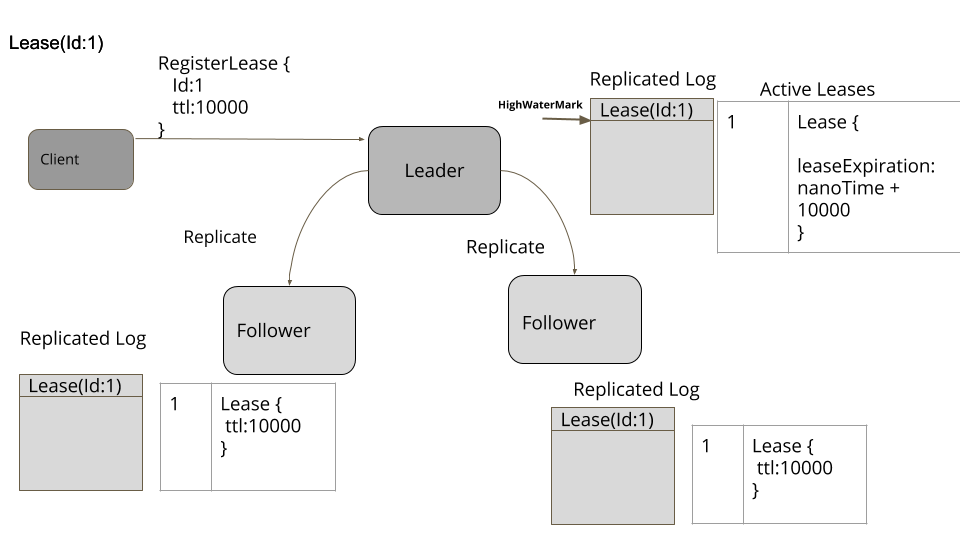

使用租约(Lease),可以在一组服务器上协调任务。同样的技术也可以用于实现分组成员信息和失效检测机制。

状态监控(State Watch),可以在元数据发生改变,或是基于时间的租约到期时,获得通知。

示例

众所周知,Google 使用 chubby 锁服务进行协调和元数据管理。

kafka 使用 zookeeper 管理元数据,以及做一些类似于为集群选举领导者之类的决策。Kafka 中提议的一个架构调整是在将来使用自己基于 raft 的控制器集群替换 Zookeeper。

bookkeeper 使用 Zookeeper 管理集群的元数据。

kubernetes 使用 etcd 进行协调、管理集群的元数据和分组成员信息。

所有的大数据存储和处理系统类似于 hdfs、spark、flink 都使用 zookeeper 实现高可用以及集群协调。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/follower-reads.html

由追随者为读取请求提供服务,获取更好的吞吐和更低的延迟。

2021.7.1

问题

使用领导者和追随者模式时,如果有太多请求发给领导者,它可能会出现过载。此外,在多数据中心的情况下,客户端如果在远程的数据中心,向领导者发送的请求可能会有额外的延迟。

解决方案

当写请求要到领导者那去维持一致性,只读请求就会转到最近的追随者。当客户端大多都是只读的,这种做法就特别有用。

值得注意的是,从追随者那里读取的客户端得到可能是旧值。领导者和追随者之间总会存在一个复制滞后,即使是在像 Raft 这样实现共识算法的系统中。这是因为即使领导者知道哪些值提交过了,它也需要另外一个消息将这个信息传达给跟随者。因此,从追随者服务器上读取信息只能用于“可以容忍稍旧的值”的情况。

找到最近的节点

集群节点要额外维护其位置的元数据。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

class ReplicaDescriptor…

public class ReplicaDescriptor {

public ReplicaDescriptor(InetAddressAndPort address, String region) {

this.address = address;

this.region = region;

}

InetAddressAndPort address;

String region;

public InetAddressAndPort getAddress() {

return address;

}

public String getRegion() {

return region;

}

}

然后,集群客户端可以根据自己的区域选取本地的副本。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

class ClusterClient{

public List<String> get(String key) {

List<ReplicaDescriptor> allReplicas = allFollowerReplicas(key);

ReplicaDescriptor nearestFollower = findNearestFollowerBasedOnLocality(allReplicas, clientRegion);

GetValueResponse getValueResponse = sendGetRequest(nearestFollower.getAddress(), new GetValueRequest(key));

return getValueResponse.getValue();

}

ReplicaDescriptor findNearestFollowerBasedOnLocality(List<ReplicaDescriptor> followers, String clientRegion) {

List<ReplicaDescriptor> sameRegionFollowers = matchLocality(followers, clientRegion);

List<ReplicaDescriptor> finalList = sameRegionFollowers.isEmpty()?followers:sameRegionFollowers;

return finalList.get(0);

}

private List<ReplicaDescriptor> matchLocality(List<ReplicaDescriptor> followers, String clientRegion) {

return followers.stream().filter(rd -> clientRegion.equals(rd.region)).collect(Collectors.toList());

}

}

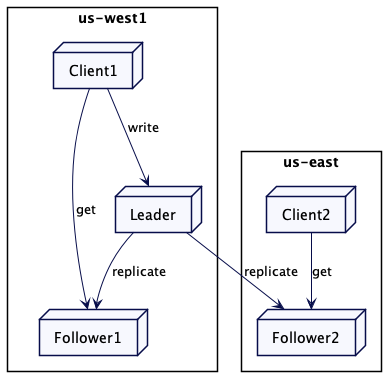

例如,如果有两个追随者副本,一个在美国西部(us-west),另一个在美国东部(us-east)。美国东部的客户端就会连接到美国东部的副本上。

1

2

3

4

5

6

7

8

class CausalKVStoreTest{

@Test

public void getFollowersInSameRegion() {

List<ReplicaDescriptor> followers = createReplicas("us-west", "us-east");

ReplicaDescriptor nearestFollower = new ClusterClient(followers, "us-east").findNearestFollower(followers);

assertEquals(nearestFollower.getRegion(), "us-east");

}

}

集群客户端或协调的集群节点也会追踪其同集群节点之间可观察的延迟。它可以发送周期性的心跳来获取延迟,并根据它选出延迟最小的追随者。为了做一个更公平的选择,像 mongodb 或 cockroachdb 这样的产品会把延迟当做滑动平均来计算。集群节点一般会同其它集群节点之间维护一个单一 Socket 通道(Single Socket Channel)进行通信。单一 Socket 通道(Single Socket Channel)会使用心跳(HeartBeat)进行连接保活。因此,获取延迟和计算滑动移动平均就可以很容易地实现。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

class WeightedAverage…

public class WeightedAverage {

long averageLatencyMs = 0;

public void update(long heartbeatRequestLatency) {

//Example implementation of weighted average as used in Mongodb

//The running, weighted average round trip time for heartbeat messages to the target node.

// Weighted 80% to the old round trip time, and 20% to the new round trip time.

averageLatencyMs = averageLatencyMs == 0 ? heartbeatRequestLatency : (averageLatencyMs * 4 + heartbeatRequestLatency) / 5;

}

public long getAverageLatency() {

return averageLatencyMs;

}

}

class ClusterClient…

private Map<InetAddressAndPort, WeightedAverage> latencyMap = new HashMap<>();

private void sendHeartbeat(InetAddressAndPort clusterNodeAddress) {

try {

long startTimeNanos = System.nanoTime();

sendHeartbeatRequest(clusterNodeAddress);

long endTimeNanos = System.nanoTime();

WeightedAverage heartbeatStats = latencyMap.get(clusterNodeAddress);

if (heartbeatStats == null) {

heartbeatStats = new WeightedAverage();

latencyMap.put(clusterNodeAddress, new WeightedAverage());

}

heartbeatStats.update(endTimeNanos - startTimeNanos);

} catch (NetworkException e) {

logger.error(e);

}

}

This latency information can then be used to pick up the follower with the least network latency.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

class ClusterClient…

ReplicaDescriptor findNearestFollower(List<ReplicaDescriptor> allFollowers) {

List<ReplicaDescriptor> sameRegionFollowers = matchLocality(allFollowers, clientRegion);

List<ReplicaDescriptor> finalList = sameRegionFollowers.isEmpty() ? allFollowers:sameRegionFollowers;

return finalList.stream().sorted((r1, r2) -> {

if (!latenciesAvailableFor(r1, r2)) {

return 0;

}

return Long.compare(latencyMap.get(r1).getAverageLatency(),

latencyMap.get(r2).getAverageLatency());

}).findFirst().get();

}

private boolean latenciesAvailableFor(ReplicaDescriptor r1, ReplicaDescriptor r2) {

return latencyMap.containsKey(r1) && latencyMap.containsKey(r2);

}

这样,就可以利用延迟信息选取网络延迟最小的追随者。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

class ClusterClient…

ReplicaDescriptor findNearestFollower(List<ReplicaDescriptor> allFollowers) {

List<ReplicaDescriptor> sameRegionFollowers = matchLocality(allFollowers, clientRegion);

List<ReplicaDescriptor> finalList = sameRegionFollowers.isEmpty() ? allFollowers : sameRegionFollowers;

return finalList.stream().sorted((r1, r2) -> {

if (!latenciesAvailableFor(r1, r2)) {

return 0;

}

return Long.compare(latencyMap.get(r1).getAverageLatency(),

latencyMap.get(r2).getAverageLatency());

}).findFirst().get();

}

private boolean latenciesAvailableFor(ReplicaDescriptor r1, ReplicaDescriptor r2) {

return latencyMap.containsKey(r1) && latencyMap.containsKey(r2);

}

断连或缓慢的追随者

追随者可能会与领导者之间失去联系,停止获得更新。在某些情况下,追随者可能会受到慢速磁盘的影响,阻碍整个的复制过程,这会导致追随者滞后于领导者。追随者追踪到其是否有一段时间没有收到领导者的消息,在这种情况下,可以停止对用户请求进行服务。

比如,像 mongodb 这样的产品会选择带有最大可接受滞后时间(maximum allowed lag time)的副本。如果副本滞后于领导者超过了这个最大时间,就不会选择它继续对用户请求提供服务。在 kafka 中,如果追随者检测到消费者请求的偏移量过大,它就会给出一个 OFFSET_OUT_OF_RANGE 的错误。我们就预期消费者会与领导者进行通信。

读自己写

从追随者服务器读取可能会有问题,当客户端写入一些东西,然后立即尝试读取它时,即便是这样常规的场景,也可能给出令人吃惊的结果。

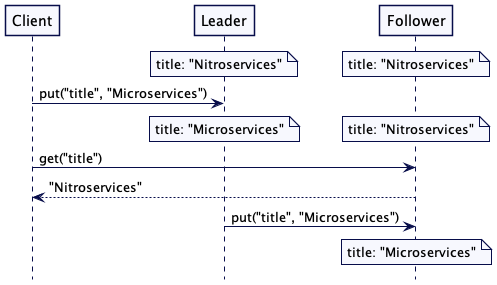

考虑这样一个情况,一个客户端注意到一些书籍数据有误,比如,“title”: “Nitroservices”。通过一次写操作,它把数据修正成 “title”: “Microservices”,这个数据要发到领导者那里。然后,这个客户端要立即读取这个值,但是,这个读的请求到了追随者,也许这个追随者还没有更新。

图 2:从追随者读取陈旧的值

This can be a common problem. For example, untill very recently Amazon S3 did not prevent this.

这可能是个常见的问题。比如,直到最近,Amazon 的 S3 也并没有完全阻止这个问题。

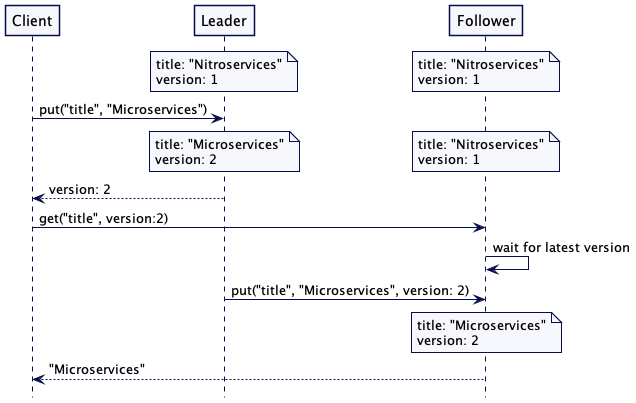

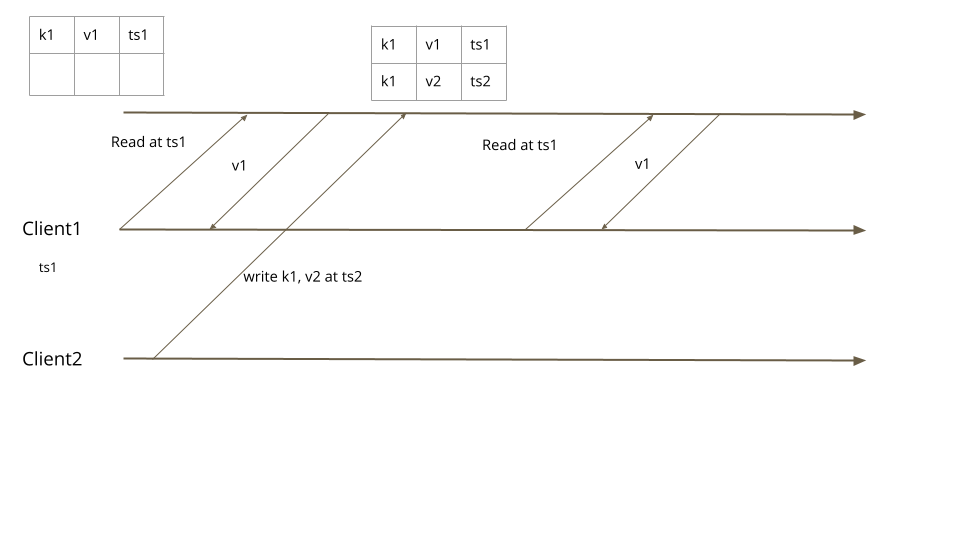

为了解决这个问题,每次写入时,服务器不仅存储新值,还有存储一个单调递增的版本戳。这个版本戳可以是高水位标记(High-Water Mark)或是混合时钟(Hybrid Clock)。然后,如果客户端希望稍后读取该值的话,它就把这个版本戳当做读取请求的一部分。如果读取请求到了追随者那里,它就会检查其存储的值,看它是等于或晚于请求的版本戳。如果不是,它就会等待,直到有了最新的版本,再返回该值。通过这种做法,这个客户端总会读取与它写入一直的值——这种做法通常称为“读自己写”的一致性。

请求流程如下所示。为了修正一个写错的值,“title”: “Microservices” 写到了领导者。在返回给客户端的应答中,领导者返回版本 2。当客户端尝试读取 “title” 的值时,它会在请求中带上版本 2。接收到这个请求的追随者服务器会检查自己的版本号是否是最新的。因为追随者的版本号还是 1,它就会等待,知道从领导者那里获取那个版本。一旦获得匹配(更晚的)版本,它就完成这个读取请求,返回值 “Microservices”。

图 3:在追随者读自己写

键值存储的代码如下所示。值得注意的是,追随者可能落后太多,或者已经与领导者失去连接。因此,它不会无限地等待。有一个配置的超时值,如果追随者无法在超时时间内得到更新,它会给客户端返回一个错误的应答。客户端之后尝试从其他追随者那里读取。

1

2

class ReplicatedKVStore…

Map<Integer, CompletableFuture> waitingRequests = new ConcurrentHashMap<>();public CompletableFuture<Optional<String>> get(String key, int atVersion) { if(this.server.serverRole() == ServerRole.FOLLOWING) { //check if we have the version with us; if (!isVersionUptoDate(atVersion)) { //wait till we get the latest version. CompletableFuture<Optional<String>> future = new CompletableFuture<>(); //Timeout if version does not progress to required version //before followerWaitTimeout ms. future.orTimeout(config.getFollowerWaitTimeoutMs(), TimeUnit.MILLISECONDS); waitingRequests.put(atVersion, future); return future; } } return CompletableFuture.completedFuture(mvccStore.get(key, atVersion));}private boolean isVersionUptoDate(int atVersion) { Optional<Integer> maxVersion = mvccStore.getMaxVersion(); return maxVersion.map(v -> v >= atVersion).orElse(false);}

一旦键值存储的内容前进到客户端请求的版本,它就可以给客户端发送应答了。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

class ReplicatedKVStore…

private Response applyWalEntry(WALEntry walEntry) {

Command command = deserialize(walEntry);

if (command instanceof SetValueCommand) {

return applySetValueCommandsAndCompleteClientRequests((SetValueCommand) command);

}

throw new IllegalArgumentException("Unknown command type " + command);

}

private Response applySetValueCommandsAndCompleteClientRequests(SetValueCommand setValueCommand) {

getLogger().info("Setting key value " + setValueCommand);

version = version + 1;

mvccStore.put(new VersionedKey(setValueCommand.getKey(), version), setValueCommand.getValue());

completeWaitingFuturesIfFollower(version, setValueCommand.getValue());

Response response = Response.success(version);

return response;

}

private void completeWaitingFuturesIfFollower(int version, String value) {

CompletableFuture completableFuture = waitingRequests.remove(version);

if (completableFuture != null) {

completableFuture.complete(Optional.of(value));

}

}

线性读

有时,读取请求需要获取最新的可用数据,复制的滞后是无法容忍的。在这种情况下,读取请求需要重定向到领导者。这是一个常见的设计问题,通常由一致性内核(Consistent Core)来解决。

示例

neo4j 允许建立因果集群(causal clusters)。每次写操作会返回一个书签,在读取副本上执行查询时会返回这个书签。这个书签会确保客户端总能获得写在书签处的值。

mongodb 会在其副本集中保持因果一致性(causal consistency)。写操作会返回一个操作时间(operationTime);这个时间会在随后的读请求中传递,以确保读请求能够返回这个读请求之前写入的数据。

cockroachdb 允许客户端从追随者服务器上进行读取。领导者服务器会在写操作完成之后发布最新的时间戳,称之为封闭时间戳(closed timestamps)。如果追随者在封闭的时间戳上有值,追随者就允许读取该值。

Kafka 允许消费来自追随者服务器的消息。追随者知道领导者的高水位标记(High-Water Mark)。在 Kafka 的设计中,追随者不会等待最新的更新,而是会给消费者返回 OFFSET_NOT_AVAILABLE 错误,期待消费者进行重试。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/generation.html

一个单调递增的数字,表示服务器的世代。

2020.8.20

又称:Term、Epoch 或世代(Generation)

问题

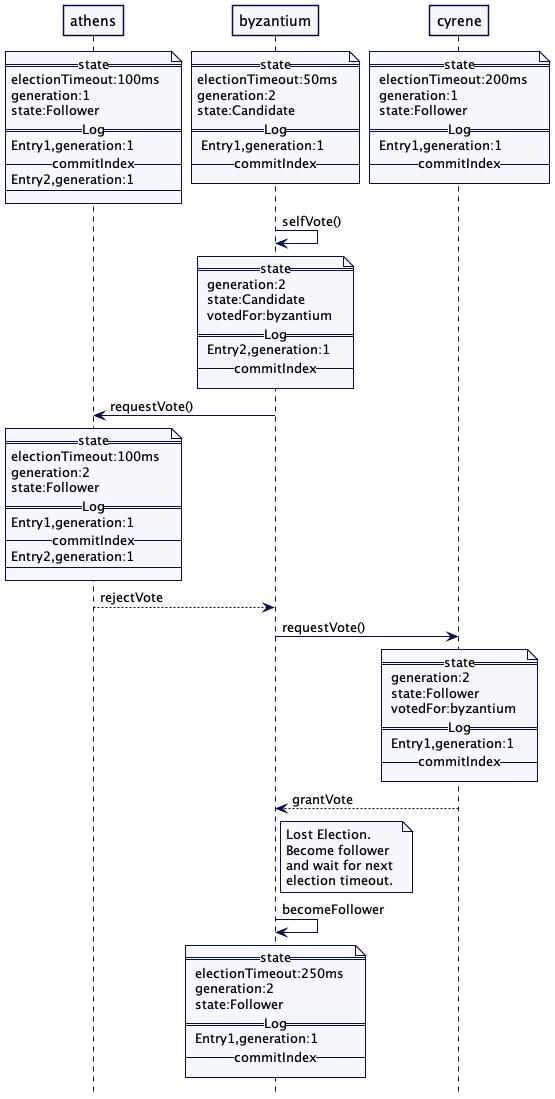

在领导者和追随者(Leader and Followers)的构建过程中,有一种可能性,领导者临时同追随者失联了。可能是因为垃圾回收造成而暂停,也可能是临时的网络中断,这些都会让领导者进程与追随者之间失联。在这种情况下,领导者进程依旧在运行,暂停之后或是网络中断停止之后,它还是会尝试发送复制请求给追随者。这么做是有危险的,因为与此同时,集群余下的部分可能已经选出了一个新的领导者,接收来自客户端的请求。有一点非常重要,集群余下的部分要能检测出有的请求是来自原有的领导者。原有的领导者本身也要能检测出,它是临时从集群中断开了,然后,采用必要的修正动作,交出领导权。

解决方案

维护一个单调递增的数字,表示服务器的世代。每次选出新的领导者,这个世代都应该递增。即便服务器重启,这个世代也应该是可用的,因此,它应该存储在预写日志(Write-Ahead Log)每一个条目里。在高水位标记(High-Water Mark)里,我们讨论过,追随者会使用这个信息找出日志中冲突的部分。

启动时,服务器要从日志中读取最后一个已知的世代。

1

2

3

class ReplicationModule{

this.replicationState = new ReplicationState(config, wal.getLastLogEntryGeneration());

}

采用领导者和追随者(Leader and Followers)模式,选举新的领导者选举时,服务器对这个世代的值进行递增。

1

2

3

4

5

6

7

class ReplicationModule{

private void startLeaderElection() {

replicationState.setGeneration(replicationState.getGeneration() + 1);

registerSelfVote();

requestVoteFrom(followers);

}

}

服务器会把世代当做投票请求的一部分发给其它服务器。在这种方式下,经过了成功的领导者选举之后,所有的服务器都有了相同的世代。一旦选出新的领导者,追随者就会被告知新的世代。

1

2

3

4

5

6

7

follower (class ReplicationModule...)

private void becomeFollower(int leaderId, Long generation) {

replicationState.setGeneration(generation);

replicationState.setLeaderId(leaderId);

transitionTo(ServerRole.FOLLOWING);

}

自此之后,领导者会在它发给追随者的每个请求中都包含这个世代信息。它也包含在发给追随者的每个心跳(HeartBeat)消息里,也包含在复制请求中。

领导者也会把世代信息持久化到预写日志(Write-Ahead Log)的每一个条目里。

1

2

3

4

5

6

7

leader (class ReplicationModule...)

Long appendToLocalLog(byte[] data) {

var logEntryId = wal.getLastLogEntryId() + 1;

var logEntry = new WALEntry(logEntryId, data, EntryType.DATA, replicationState.getGeneration());

return wal.writeEntry(logEntry);

}

按照这种做法,它还会持久化在追随者日志中,作为领导者和追随者(Leader and Followers)复制机制的一部分。

如果追随者得到了一个来自已罢免领导的消息,追随者就可以告知其世代过低。追随者会给出一个失败的应答。

1

2

3

4

5

6

7

follower (class ReplicationModule...)

Long currentGeneration = replicationState.getGeneration();

if (currentGeneration > replicationRequest.getGeneration()) {

return new ReplicationResponse(FAILED, serverId(), currentGeneration, wal.getLastLogEntryId());

}

当领导者得到了一个失败的应答,它就会变成追随者,期待与新的领导者建立通信。

1

2

3

4

5

6

7

8

9

10

11

12

Old leader (class ReplicationModule...)

if (!response.isSucceeded()) {

stepDownIfHigherGenerationResponse(response);

return;

}

private void stepDownIfHigherGenerationResponse(ReplicationResponse replicationResponse) {

if (replicationResponse.getGeneration() > replicationState.getGeneration()) {

becomeFollower(-1, replicationResponse.getGeneration());

}

}

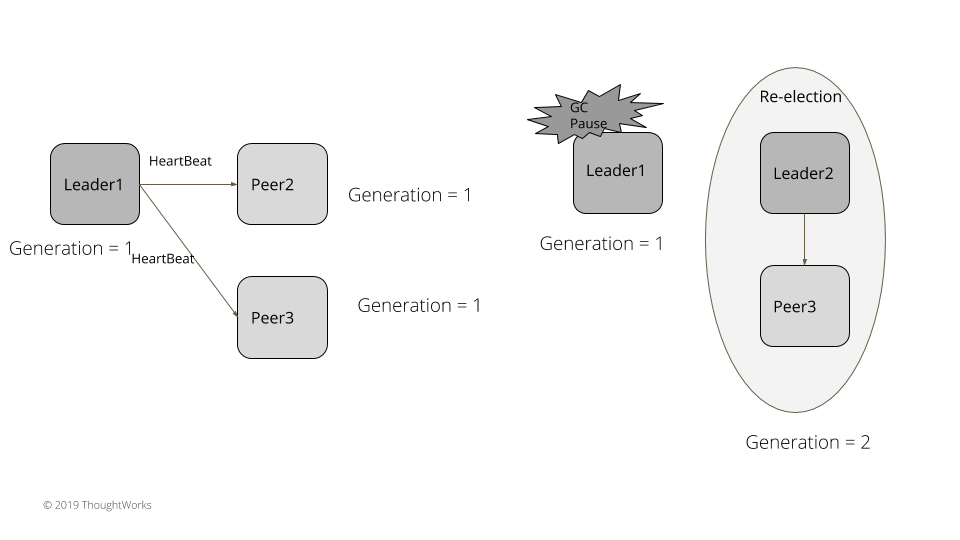

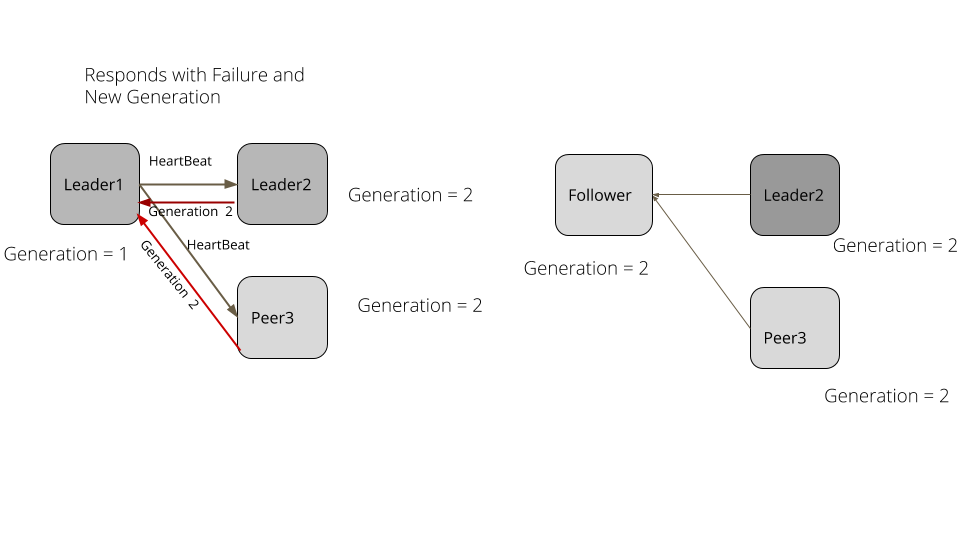

考虑一下下面这个例子。在一个服务器集群里,leader1 是既有的领导者。集群里所有服务器的世代都是 1。leader1 持续发送心跳给追随者。leader1 产生了一次长的垃圾收集暂停,比如说,5 秒。追随者没有得到心跳,超时了,然后选举出新的领导者。新的领导者将世代递增到 2。垃圾收集暂停结束之后,leader1 持续发送请求给其它服务器。追随者和新的领导者现在都是世代 2 了,拒绝了其请求,发送一个失败应答,其中的世代是 2。leader1 处理失败的应答,退下来成为一个追随者,将世代更新成 2。

图1:世代

示例

Raft

Raft 使用了 Term 的概念标记领导者世代。

Zab

在 Zookeeper 里,每个 epoch 数是作为每个事务 ID 的一部分进行维护的。因此,每个持久化在 Zookeeper 里的事务都有一个世代,通过 epoch 表示。

Cassandra

在 Cassandra 里,每个服务器都存储了一个世代数字,每次服务器重启时都会递增。世代信息持久化在系统的键值空间里,也作为 Gossip 消息的一部分传给其它服务器。服务器接收到 Gossip 消息之后,将它知道的世代值与 Gossip 消息的世代值进行比较。如果 Gossip 消息中世代更高,它就知道服务器重启了,然后,丢弃它维护的关于这个服务器的所有状态,请求新的状态。

Kafka 中的 Epoch

Kafka 每次为集群选出新的控制器,都会创建一个 epoch 数,将其存在 Zookeeper 里。epoch 会包含在集群里从控制器发到其它服务器的每个请求中。它还维护了另外一个 epoch,称为 LeaderEpoch,以便了解一个分区的追随者是否落后于其高水位标记(High-Water Mark)。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/gossip-dissemination.html

使用节点的随机选择进行信息传递,以确保信息可以到达集群中的所有节点,而不会淹没网络。

2021.6.17

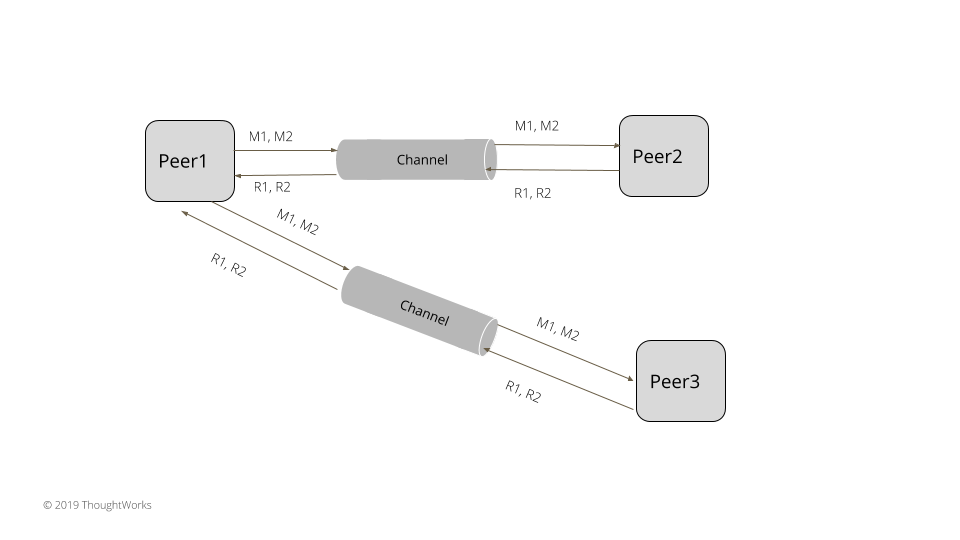

问题

在拥有多个节点的集群中,每个节点都要向集群中的所有其它节点传递其所拥有的元数据信息,无需依赖于共享存储。在一个很大的集群里,如果所有的服务器要和所有其它的服务器通信,就会消耗大量的网络带宽。信息应该能够到达所有节点,即便有些网络连接遇到一些问题。

在大型的集群中,需要考虑下面一些东西:

- 对每台服务器产生的信息数量进行固定的限制

- 消息不应消耗大量的网络带宽。应该有一个上限,比如说几百 Kbs,确保不会因为集群中有过多的消息影响到应用的数据传输。

- 元数据的传播应该可以容忍网络和部分服务器的失效。即便有一些网络链接中断,或是有部分服务器失效,消息也能到达所有的服务器节点。

正如边栏中所讨论的,Gossip 式的通信满足了所有这些要求。

每个集群节点都把元数据存储为一个键值对列表,每个键值都到关联集群的一个节点,就像下面这样:

1

2

3

4

5

6

7

class Gossip{

Map<NodeId, NodeState> clusterMetadata = new HashMap<>();

class NodeState…

Map<String, VersionedValue> values = new HashMap<>();

}

启动时,每个集群节点都会添加关于自己的元数据,这些元数据需要传播给其他节点。元数据的一个例子可以是节点监听的 IP 地址和端口,它负责的分区等等。Gossip 实例需要知晓至少一个其它节点的情况,以便开始进行 Gossip 通信。有一个集群节点需要众所周知,用于初始化 Gossip 实例,这个节点称为种子节点(a seed node),或者创始节点(introducer)。任何节点都可以充当创始节点。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

class Gossip{

public Gossip(InetAddressAndPort listenAddress,

List<InetAddressAndPort> seedNodes,

String nodeId) throws IOException {

this.listenAddress = listenAddress;

//filter this node itself in case its part of the seed nodes

this.seedNodes = removeSelfAddress(seedNodes);

this.nodeId = new NodeId(nodeId);

addLocalState(GossipKeys.ADDRESS, listenAddress.toString());

this.socketServer = new NIOSocketListener(newGossipRequestConsumer(), listenAddress);

}

private void addLocalState(String key, String value) {

NodeState nodeState = clusterMetadata.get(listenAddress);

if (nodeState == null) {

nodeState = new NodeState();

clusterMetadata.put(nodeId, nodeState);

}

nodeState.add(key, new VersionedValue(value, incremenetVersion()));

}

}

每个集群节点都会调度一个 job 用以定期将其拥有的元数据传输给其他节点。

1

2

3

4

5

6

7

8

9

10

class Gossip{

private ScheduledThreadPoolExecutor gossipExecutor = new ScheduledThreadPoolExecutor(1);

private long gossipIntervalMs = 1000;

private ScheduledFuture<?> taskFuture;

public void start() {

socketServer.start();

taskFuture = gossipExecutor.scheduleAtFixedRate(()-> doGossip(), gossipIntervalMs, gossipIntervalMs, TimeUnit.MILLISECONDS);

}

}

调用调度任务时,它会从元数据集合的服务器列表中随机选取一小群节点。我们会定义一个小的常数,称为 Gossip 扇出,它会确定会选取多少节点称为 Gossip 的目标。如果什么都不知道,它会随机选取一个种子节点,然后发送其拥有的元数据集合给该节点。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

class Gossip{

public void doGossip() {

List<InetAddressAndPort> knownClusterNodes = liveNodes();

if (knownClusterNodes.isEmpty()) {

sendGossip(seedNodes, gossipFanout);

} else {

sendGossip(knownClusterNodes, gossipFanout);

}

}

private List<InetAddressAndPort> liveNodes() {

Set<InetAddressAndPort> nodes = clusterMetadata.values()

.stream()

.map(n -> InetAddressAndPort.parse(n.get(GossipKeys.ADDRESS).getValue()))

.collect(Collectors.toSet());

return removeSelfAddress(nodes);

}

private void sendGossip(List<InetAddressAndPort> knownClusterNodes, int gossipFanout) {

if (knownClusterNodes.isEmpty()) {

return;

}

for (int i = 0; i < gossipFanout; i++) {

InetAddressAndPort nodeAddress = pickRandomNode(knownClusterNodes);

sendGossipTo(nodeAddress);

}

}

private void sendGossipTo(InetAddressAndPort nodeAddress) {

try {

getLogger().info("Sending gossip state to " + nodeAddress);

SocketClient<RequestOrResponse> socketClient = new SocketClient(nodeAddress);

GossipStateMessage gossipStateMessage = new GossipStateMessage(this.clusterMetadata);

RequestOrResponse request = createGossipStateRequest(gossipStateMessage);

byte[] responseBytes = socketClient.blockingSend(request);

GossipStateMessage responseState = deserialize(responseBytes);

merge(responseState.getNodeStates());

} catch (IOException e) {

getLogger().error("IO error while sending gossip state to " + nodeAddress, e);

}

}

private RequestOrResponse createGossipStateRequest(GossipStateMessage gossipStateMessage) {

return new RequestOrResponse(RequestId.PushPullGossipState.getId(), JsonSerDes.serialize(gossipStateMessage), correlationId++);

}

}

接收 Gossip 消息的集群节点会检查其拥有的元数据,发现三件事。

- 传入消息中的值,且不再该节点状态集合中

- 该节点拥有,但不再传入的 Gossip 消息中

- 节点拥有传入消息的值,这时会选择版本更高的值

稍后,它会将缺失的值添加到自己的状态集合中。传入消息中若有任何值缺失,就会在应答中返回这些值。

发送 Gossip 消息的集群节点会将从 Gossip 应答中得到值添加到自己的状态中。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

class Gossip…

private void handleGossipRequest(org.distrib.patterns.common.Message<RequestOrResponse> request) {

GossipStateMessage gossipStateMessage = deserialize(request.getRequest());

Map<NodeId, NodeState> gossipedState = gossipStateMessage.getNodeStates();

getLogger().info("Merging state from " + request.getClientSocket());

merge(gossipedState);

Map<NodeId, NodeState> diff = delta(this.clusterMetadata, gossipedState);

GossipStateMessage diffResponse = new GossipStateMessage(diff);

getLogger().info("Sending diff response " + diff);

request.getClientSocket().write(new RequestOrResponse(RequestId.PushPullGossipState.getId(), JsonSerDes.serialize(diffResponse), request.getRequest().getCorrelationId()));

}

public Map<NodeId, NodeState> delta(Map<NodeId, NodeState> fromMap, Map<NodeId, NodeState> toMap) {

Map<NodeId, NodeState> delta = new HashMap<>();

for (NodeId key : fromMap.keySet()) {

if (!toMap.containsKey(key)) {

delta.put(key, fromMap.get(key));

continue;

}

NodeState fromStates = fromMap.get(key);

NodeState toStates = toMap.get(key);

NodeState diffStates = fromStates.diff(toStates);

if (!diffStates.isEmpty()) {

delta.put(key, diffStates);

}

}

return delta;

}

public void merge(Map<NodeId, NodeState> otherState) {

Map<NodeId, NodeState> diff = delta(otherState, this.clusterMetadata);

for (NodeId diffKey : diff.keySet()) {

if(!this.clusterMetadata.containsKey(diffKey)) {

this.clusterMetadata.put(diffKey, diff.get(diffKey));

} else {

NodeState stateMap = this.clusterMetadata.get(diffKey);

stateMap.putAll(diff.get(diffKey));

}

}

}

每隔一秒,这个过程就会在集群的每个节点上发生一次,每次都会选择不同的节点进行状态交换。

避免不必要的状态交换

上面的代码例子显示,在 Gossip 消息里发送了节点的完整状态。对于新加入的节点,这是没问题的,但一旦状态是最新的,就没有必要发送完整状态了。集群节点只需要发送自上个 Gossip 消息以来的状态变化。为了实现这一点,每个节点都维护着一个版本号,每当本地添加了一个新的元数据条目,这个版本就会递增一次。

1

2

3

4

5

6

7

class Gossip…

private int gossipStateVersion = 1;

private int incremenetVersion() {

return gossipStateVersion++;

}

集群元数据的每个值都维护有一个版本号。这就是有版本的值(Versioned Value)这个模式的一个例子。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

class VersionedValue{

int version;

String value;

public VersionedValue(String value, int version) {

this.version = version;

this.value = value;

}

public int getVersion() {

return version;

}

public String getValue() {

return value;

}

}

之后,每个 Gossip 循环都可以交换从特定版本开始的状态。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

class Gossip{

private void sendKnownVersions(InetAddressAndPort gossipTo) throws IOException {

Map<NodeId, Integer> maxKnownNodeVersions = getMaxKnownNodeVersions();

RequestOrResponse knownVersionRequest = new RequestOrResponse(RequestId.GossipVersions.getId(), JsonSerDes.serialize(new GossipStateVersions(maxKnownNodeVersions)), 0);

SocketClient<RequestOrResponse> socketClient = new SocketClient(gossipTo);

byte[] knownVersionResponseBytes = socketClient.blockingSend(knownVersionRequest);

}

private Map<NodeId, Integer> getMaxKnownNodeVersions() {

return clusterMetadata.entrySet()

.stream()

.collect(Collectors.toMap(e -> e.getKey(), e -> e.getValue().maxVersion()));

}}

class NodeState{

public int maxVersion() {

return values.values().stream().map(v -> v.getVersion()).max(Comparator.naturalOrder()).orElse(0);

}

}

再之后,接收节点只会把版本号大于请求中版本号的那些值发送出去。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

class Gossip{

Map<NodeId, NodeState> getMissingAndNodeStatesHigherThan(Map<NodeId, Integer> nodeMaxVersions) {

Map<NodeId, NodeState> delta = new HashMap<>();

delta.putAll(higherVersionedNodeStates(nodeMaxVersions));

delta.putAll(missingNodeStates(nodeMaxVersions));

return delta;

}

private Map<NodeId, NodeState> missingNodeStates(Map<NodeId, Integer> nodeMaxVersions) {

Map<NodeId, NodeState> delta = new HashMap<>();

List<NodeId> missingKeys = clusterMetadata.keySet().stream().filter(key -> !nodeMaxVersions.containsKey(key)).collect(Collectors.toList());

for (NodeId missingKey : missingKeys) {

delta.put(missingKey, clusterMetadata.get(missingKey));

}

return delta;

}

private Map<NodeId, NodeState> higherVersionedNodeStates(Map<NodeId, Integer> nodeMaxVersions) {

Map<NodeId, NodeState> delta = new HashMap<>();

Set<NodeId> keySet = nodeMaxVersions.keySet();

for (NodeId node : keySet) {

Integer maxVersion = nodeMaxVersions.get(node);

NodeState nodeState = clusterMetadata.get(node);

if (nodeState == null) {

continue;

}

NodeState deltaState = nodeState.statesGreaterThan(maxVersion);

if (!deltaState.isEmpty()) {

delta.put(node, deltaState);

}

}

return delta;

}

}

cassandra 的 Gossip 实现通过三次握手优化了状态交换,接收 Gossip 消息的节点也会发出它在发送者那里所需的版本,以及它返回的元数据。然后,发送者立即在应答中给出了请求的元数据。这样就避免原本需要的额外消息。

cockroachdb 使用的 Gossip 协议维护每个相连节点的状态。对每个连接来说,它都维护着发送给那个节点最后的版本,以及从那个节点接收到的版本。这是为了让它能够发送“从最后发送的版本以来的值”,以及请求“从最后收到版本开始的状态”。

还可以使用其它的一些高效的替代方案,比如,发送整个状态集的哈希值,如果哈希值相同,则什么都不做。

Gossip 节点选择的标准

集群节点可以随机选择节点发送 Gossip 消息。下面是一个用 Java 实现的例子,使用了 java.util.Random:

1

2

3

4

5

6

7

8

class Gossip{

private Random random = new Random();

private InetAddressAndPort pickRandomNode(List<InetAddressAndPort> knownClusterNodes) {

int randomNodeIndex = random.nextInt(knownClusterNodes.size());

InetAddressAndPort gossipTo = knownClusterNodes.get(randomNodeIndex);

return gossipTo;

}

}

还可以有其它的考量,比如,选择之前联系最少的节点。比如,Cockroachdb 的 Gossip 协议就是这么选择节点的。

还存在一些感知网络拓扑(network-topology-aware)的 Gossip 目标选择的方式。

所有这些方法都可以以模块化的方式实现在 pickRandomNode() 方法里。

分组成员和失效检测

维护集群中的可用节点列表是 Gossip 协议最常见的用法之一。有两种方式在使用。

- swim-gossip 使用了一个单独的探测组件,它会不断地探测集群中的不同节点,以检测它们是否可用。如果它检测到某个节点是活的或死的,这个结果会通过 Gossip 通信传播给整个集群。探测器会随机选择一个节点发送 Gossip 消息。如果接收节点检测这是一条新的消息,它会立即将消息发送给一个随机选择的节点。这样,如果集群中有节点失效或者有新加入的节点,整个集群很快就都知道了。

- 集群节点可以定期更新自己的状态以反映其心跳,稍后,这种状态通过 Gossip 消息的交换传播到整个集群。然后,每个集群节点都可以检查它是否在固定的时间内收到某个特定集群节点的更新,否则,就将该节点标记为宕机。在这种情况下,每个集群节点独立地确定一个节点是在运行中还是宕机了。

处理节点重启

在节点崩溃或重启的情况下,有版本的值就不能很好的运作了,因为所有的内存状态都会丢失。更重要的是,对于同样的键值,节点可能会有不同的值。比如,集群节点以不同的 IP 地址和端口启动,或是以不同配置启动。世代时钟(Generation Clock)可以用来标记每个值的世代,因此,当元数据状态发送给一个随机的集群节点,接收的节点就不仅可以凭借版本号,还可以用世代信息检测变化。

值得注意的是,对于 Gossip 协议的工作而言,这个机制并非必要的。但在实践中,这个实现能够确保状态变化得到正确地跟踪。

示例

cassandra 使用 Gossip 协议处理集群节点的分组成员和失效检测。每个集群节点的元数据,诸如分配给每个集群节点的令牌,也使用 Gossip 协议进行传输。

consul 使用 swim-gossip 协议处理 consul 代理的分组成员和失效检测。

cockroachdb 使用 Gossip 协议传播节点的元数据。

像 Hyperledger Fabric 这样的区块链实现会使用 Gossip 协议处理分组成员以及发送账本的元数据。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/heartbeat.html

通过周期性地发送消息给所有其它服务器,表明一个服务器处于可用状态。

2020.8.20

问题

如果集群里有多个服务器,根据所用的分区和复制的模式,各个服务器都要负责存储一部分数据。及时检测出服务器的失败是很重要的,这样可以确保采用一些修正的行动,让其它服务器负责处理失败服务器对应数据的请求。

解决方案

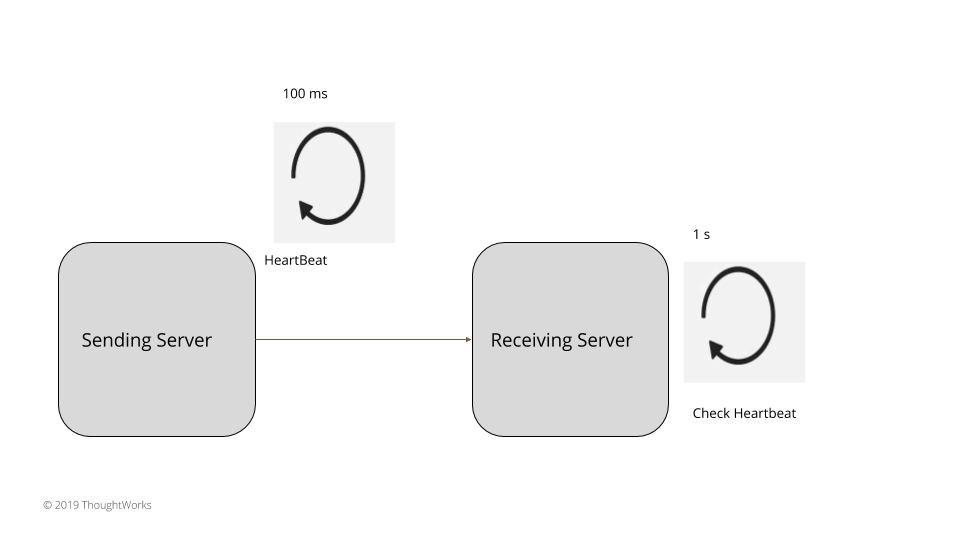

图1:心跳

一个服务器周期性地发送请求给所有其它的服务器,以此表明它依然活跃。选择的请求间隔应该大于服务器间的网络往返的时间。所有的服务器在检查心跳时,都要等待一个超时间隔,超时间隔应该是多个请求间隔。通常来说,

超时间隔 > 请求间隔 > 服务器间的网络往返时间

比如,如果服务器间的网络往返时间是 20ms,心跳可以每 100ms 发送一次,服务器检查在 1s 之后执行,这样就给了多个心跳足够的时间,不会产生漏报。如果在这个间隔里没收到心跳,就可以说发送服务器已经失效了。

无论是发送心跳的服务器,还是接收心跳的服务器,都有一个调度器,定义如下。调度器会接受一个方法,以固定的间隔执行。启动时,任务就会开始调度,执行给定的方法。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

class HeartBeatScheduler {

public class HeartBeatScheduler implements Logging {

private ScheduledThreadPoolExecutor executor = new ScheduledThreadPoolExecutor(1);

private Runnable action;

private Long heartBeatInterval;

public HeartBeatScheduler(Runnable action, Long heartBeatIntervalMs) {

this.action = action;

this.heartBeatInterval = heartBeatIntervalMs;

}

private ScheduledFuture<?> scheduledTask;

public void start() {

scheduledTask = executor.scheduleWithFixedDelay(new HeartBeatTask(action), heartBeatInterval, heartBeatInterval, TimeUnit.MILLISECONDS);

}

}

}

在发送端的服务器,调度器会执行方法,发送心跳消息。

1

2

3

4

5

class SendingServer {

private void sendHeartbeat() throws IOException {

socketChannel.blockingSend(newHeartbeatRequest(serverId));

}

}

在接收端的服务器,失效检测机制要启动一个类似的调度器。在固定的时间间隔,检查心跳是否收到。

1

2

3

4

5

6

7

class AbstractFailureDetector {

private HeartBeatScheduler heartbeatScheduler = new HeartBeatScheduler(this::heartBeatCheck, 100l);

abstract void heartBeatCheck();

abstract void heartBeatReceived(T serverId);

}

失效检测器需要有两个方法:

- 接收服务器接收到心跳调用的方法,告诉失效检测器,心跳收到了。

1

2

3

4

5

6

7

8

9

10

11

12

class ReceivingServer {

private void handleRequest(Message<RequestOrResponse> request) {

RequestOrResponse clientRequest = request.getRequest();

if (isHeartbeatRequest(clientRequest)) {

HeartbeatRequest heartbeatRequest = JsonSerDes.deserialize(clientRequest.getMessageBodyJson(), HeartbeatRequest.class);

failureDetector.heartBeatReceived(heartbeatRequest.getServerId());

sendResponse(request);

} else {

//processes other requests

}

}

}

- 一个周期性调用的方法,检查心跳状态,检测可能的失效。

什么时候将服务器标记为失效,这个实现取决于不同的评判标准。其中是有一些权衡的。总的来说,心跳间隔越小,失效检测得越快,但是,也就更有可能出现失效检测的误报。因此,心跳间隔和心跳丢失的解释是按照集群的需求来的。总的来说,分成下面两大类。

小集群,比如,像Raft、Zookeeper等基于共识的系统

在所有的共识实现中,心跳是从领导者服务器发给所有追随者服务器的。每次收到心跳,都要记录心跳到达的时间戳。

1

2

3

4

5

6

7

8

class TimeoutBasedFailureDetector {

@Override

void heartBeatReceived(T serverId) {

Long currentTime = System.nanoTime();

heartbeatReceivedTimes.put(serverId, currentTime);

markUp(serverId);

}

}

如果固定的时间窗口内没有收到心跳,就可以认为领导者崩溃了,需要选出一个新的服务器成为领导者。由于进程或网络缓慢,可能会一些虚报的失效。因此,世代时钟(Generation Clock)常用来检测过期的领导者。这就给系统提供了更好的可用性,这样很短的时间周期里就能检测出崩溃。对于比较小的集群,这很适用,典型的就是有三五个节点,大多数共识实现比如 Zookeeper 或 Raft 都是这样的。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

class TimeoutBasedFailureDetector {

@Override

void heartBeatCheck() {

Long now = System.nanoTime();

Set<T> serverIds = heartbeatReceivedTimes.keySet();

for (T serverId : serverIds) {

Long lastHeartbeatReceivedTime = heartbeatReceivedTimes.get(serverId);

Long timeSinceLastHeartbeat = now - lastHeartbeatReceivedTime;

if (timeSinceLastHeartbeat >= timeoutNanos) {

markDown(serverId);

}

}

}

}

技术考量

采用单一 Socket 通道(Single Socket Channel)在服务器间通信时,有一点需要考虑,就是队首阻塞(head-of-line-blocking),这会让心跳消息得不到处理。这样一来,延迟就会非常长,以致于产生虚报,认为发送服务器已经宕机,即便它还在按照固定的间隔发送心跳。使用请求管道(Request Pipeline),可以保证服务器在发送心跳之前不必等待之前请求的应答回来。有时,使用单一更新队列(Singular Update Queue),像写磁盘这样的任务,就可能会造成延迟,这可能会延迟定时中断的处理,也会延迟发送心跳。

这个问题可以通过在单独的线程中异步发送心跳来解决。类似于 consul 和 akka 这样的框架都会异步发送心跳。对于接收者服务器同样也是一个问题。接收服务器也要进行磁盘写,检查心跳只能在写完成后才能检查心跳,这就会造成虚报的失效检测。因此接收服务器可以使用单一更新队列(Singular Update Queue),解决心跳检查机制的延迟问题。raft 的参考实现、log-cabin 就是这么做的。

有时,一些运行时特定事件,比如垃圾收集,会造成本地停顿,进而造成心跳处理的延迟。这就需要有一种机制在本地暂停(可能)发生后,检查心跳处理是否发生过。一个简单的机制就是,在一段足够长的时间窗口之后(如,5s),检查是否有心跳。在这种情况下,如果在这个时间窗口内不需要标记为心跳失效,那么就进入到下一个循环。Cassandra 的实现就是这种做法的一个很好的示例。

大集群,基于 Gossip 的协议

前面部分描述的心跳机制,并不能扩展到大规模集群,也就是那种有几百到上千台服务器,横跨广域网的集群。在大规模集群中,有两件事要考虑:

- 每台服务器生成的消息数量要有一个固定的限制。

- 心跳消息消耗的总共的带宽。它不该消耗大量的网络带宽。应该有个几百 K 字节的上限,确保即便有太多的心跳也不会影响到在集群上实际传输的数据。

基于这些原因,应该避免所有节点对所有节点的心跳。在这些情况下,通常会使用失效检测器,以及 Gossip 协议,在集群中传播失效信息。在失效的场景下,这些集群会采取一些行动,比如,在节点间搬运数据,因此,集群会倾向于进行正确性的检测,容忍更多的延迟(虽然是有界的)。这里的主要挑战在于,不要因为网络的延迟或进程的缓慢,造成对于节点失效的虚报。那么,一种常用的机制是,给每个进程分配一个怀疑计数,在限定的时间内,如果没有收到该进程的 Gossip 消息,则怀疑计数递增。它可以根据过去的统计信息计算出来,只有在这个怀疑计数到达配置的上限时,才将其标记为失效。

有两种主流的实现:

据说 Akka 尝试过 2400 台服务器。Hashicorp Consul 在一个群组内常规部署了几千台 consul 服务器。有一个可靠的失效检测器,可以有效地用于大规模集群部署,同时,又能提供一些一致性保证,这仍然是一个积极发展中的领域。最近在一些框架的研究看上去非常有希望,比如 Rapid。

示例

- 共识实现,诸如 ZAB 或 RAFT,可以在三五个节点的集群中很好的运行,实现了基于固定时间窗口的失效检测。

- Akka Actor 和 Cassandra 采用 Phi Accrual 的失效检测器。

- Hashicorp consul 采用了基于 Gossip 的失效检测器 SWIM。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/high-watermark.html

预写日志中的索引,表示最后一次成功的复制。

2020.8.5

又称:提交索引

问题

预写日志(Write-Ahead Log)模式用于在服务器奔溃重启之后恢复状态。但在服务器失效的情况下,想要保障可用性,仅有预写日志是不够的。如果单个服务器失效了,只有等到服务器重启之后,客户端才能够继续使用其功能。为了得到一个更可用的系统,我们需要将日志复制到多台服务器上。使用领导者和追随者(Leader and Followers)时,领导者会将所有的日志条目都复制到追随者的 Quorum 上。如果领导者失效了,集群会选出一个新的领导者,客户端在大部分情况下还是能像从前一样继续在集群中工作。但是,还有几件事可能会有问题:

- 在向任意的追随者发送日志条目之前,领导者失效了。

- 给一部分追随者发送日志条目之后,领导者失效了,日志条目没有发送给大部分的追随者。

在这些错误的场景下,一部分追随者的日志中可能会缺失一些条目,一部分追随者则拥有比其它部分多的日志条目。因此,对于每个追随者来说,有一点变得很重要,了解日志中哪个部分是安全的,对客户端是可用的。

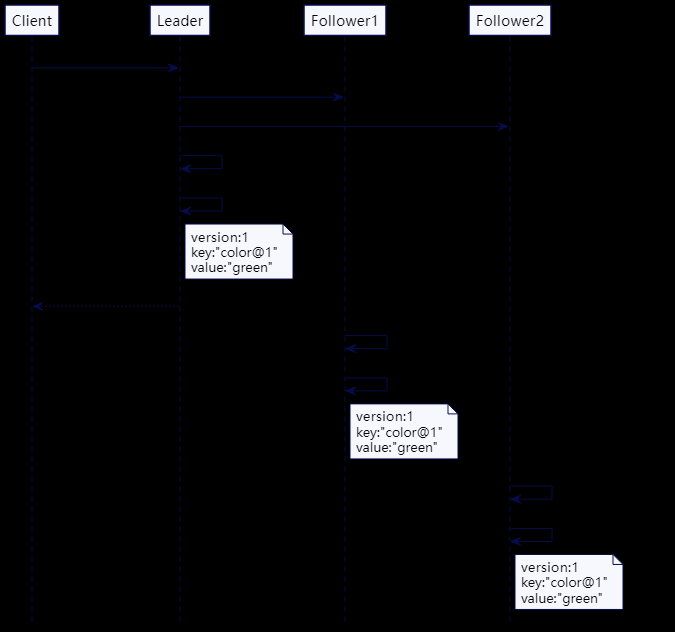

解决方案

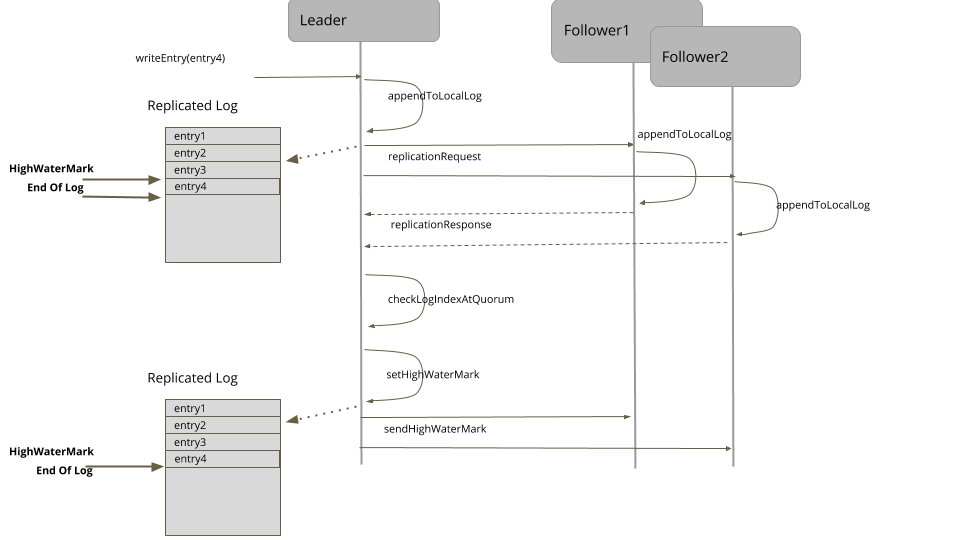

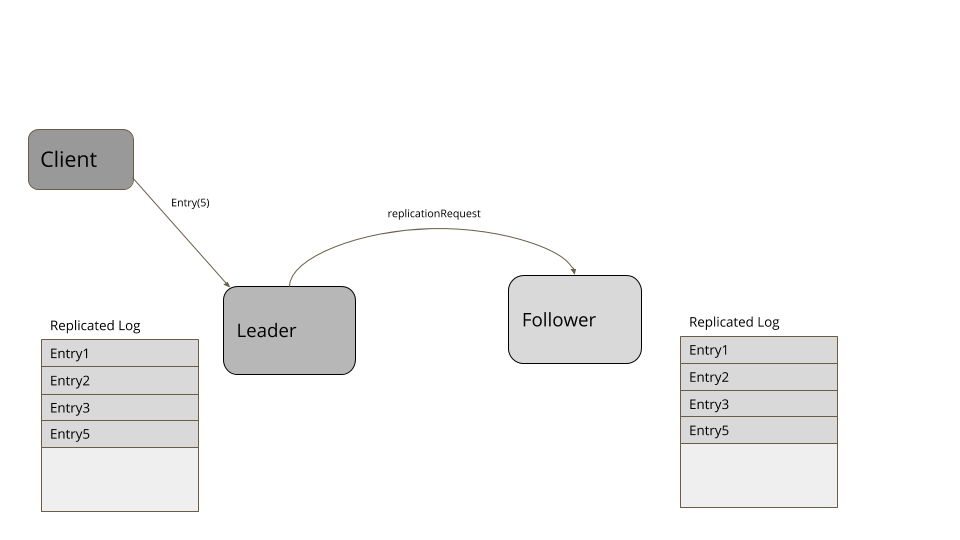

高水位标记就是一个日志文件中的索引,记录了在追随者的 Quorum 中都成功复制的最后一个日志条目。在复制期间,领导者也会把高水位标记传给追随者。对于集群中的所有服务器而言,只有反映的更新小于高水位标记的数据才能传输给客户端。

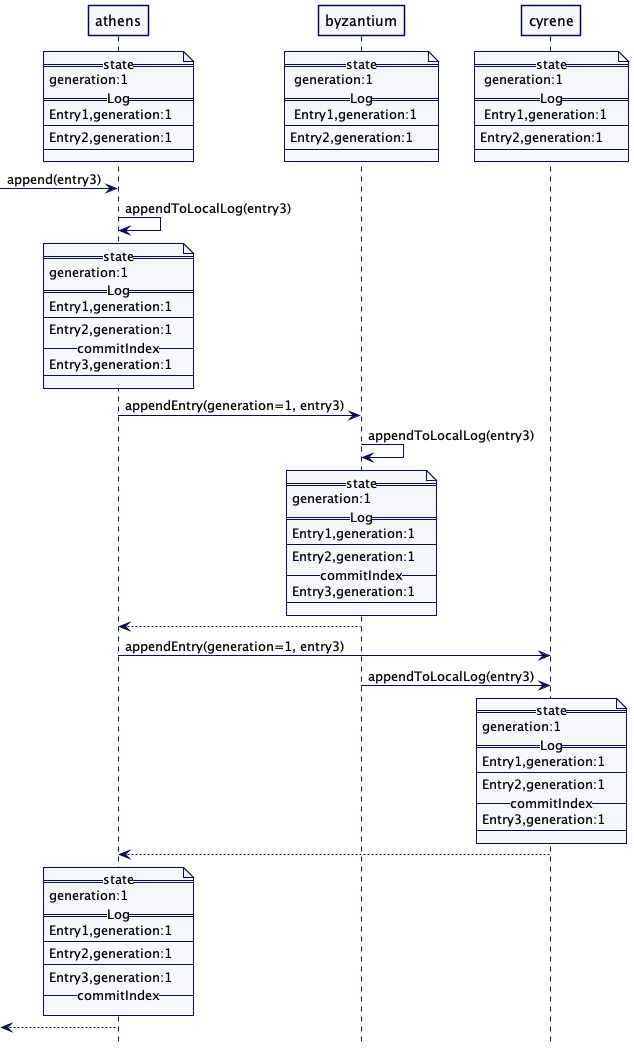

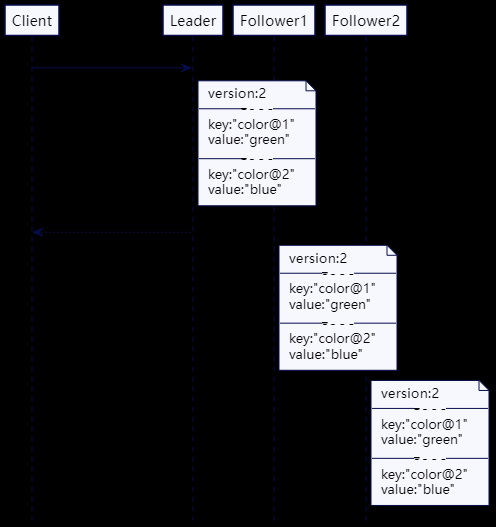

下面是这个操作的序列图。

图1:高水位标记

对于每个日志条目而言,领导者将其追加到本地的预写日志中,然后,发送给所有的追随者。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

leader(class ReplicationModule...)

private Long appendAndReplicate(byte[] data) {

Long lastLogEntryIndex = appendToLocalLog(data);

logger.info("Replicating log entries till index " + lastLogEntryIndex + " on followers");

replicateOnFollowers(lastLogEntryIndex);

return lastLogEntryIndex;

}

private void replicateOnFollowers(Long entryAtIndex) {

for (final FollowerHandler follower : followers) {

replicateOn(follower, entryAtIndex);

//send replication requests to followers

}

}

追随者会处理复制请求,将日志条目追加到本地日志中。在成功地追加日志条目之后,它们会把最新的日志条目索引回给领导者。应答中还包括服务器当前的时代时钟(Generation Clock)。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

follower(class ReplicationModule...)

private ReplicationResponse handleReplicationRequest(ReplicationRequest replicationRequest) {

List<WALEntry> entries = replicationRequest.getEntries();

for (WALEntry entry : entries) {

logger.info("Appending log entry " + entry.getEntryId() + " in " + serverId());

if (wal.exists(entry)) {

logger.info("Entry " + wal.readAt(entry.getEntryId()) + " already exists on " + config.getServerId());

continue;

}

wal.writeEntry(entry);

}

return new ReplicationResponse(SUCCEEDED, serverId(), replicationState.getGeneration(), wal.getLastLogEntryId());

}

领导者在收到应答时,会追踪每台服务器上已复制日志的索引。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

class ReplicationModule {

recordReplicationConfirmedFor(response.getServerId(),response.

getReplicatedLogIndex());

long logIndexAtQuorum = computeHighwaterMark(logIndexesAtAllServers(), config.numberOfServers()); logger.info("logIndexAtQuorum in "+config.getServerId()+" is "+logIndexAtQuorum +" highWaterMark is "+replicationState.getHighWaterMark());

var currentHighWaterMark = replicationState.getHighWaterMark(); if(logIndexAtQuorum >currentHighWaterMark)

{

applyLogAt(currentHighWaterMark, logIndexAtQuorum);

logger.info("Setting highwatermark in " + config.getServerId() + " to " + logIndexAtQuorum);

replicationState.setHighWaterMark(logIndexAtQuorum);

} else

{

logger.info("HighWaterMark in " + config.getServerId() + " is " + replicationState.getHighWaterMark() + " >= " + logIndexAtQuorum);

}

}

通过查看所有追随者的日志索引和领导者自身的日志,高水位标记是可以计算出来的,选取大多数服务器中可用的索引即可。

1

2

3

4

5

6

class ReplicationModule {

Long computeHighwaterMark(List<Long> serverLogIndexes, int noOfServers) {

serverLogIndexes.sort(Long::compareTo);

return serverLogIndexes.get(noOfServers / 2);

}

}

领导者会将高水位标记传播给追随者,可能是当做常规心跳的一部分,也可能一个单独的请求。追随者随后据此设置自己的高水位标记。

客户端只能读取到高水位标记前的日志条目。超出高水位标记的对客户端是不可见的。因为这些条目是否复制还未确认,如果领导者失效了,其它服务器成了领导者,这些条目就是不可用的。

1

2

3

4

5

6

7

8

class ReplicationModule {

public WALEntry readEntry(long index) {

if (index > replicationState.getHighWaterMark()) {

throw new IllegalArgumentException("Log entry not available");

}

return wal.readAt(index);

}

}

日志截断

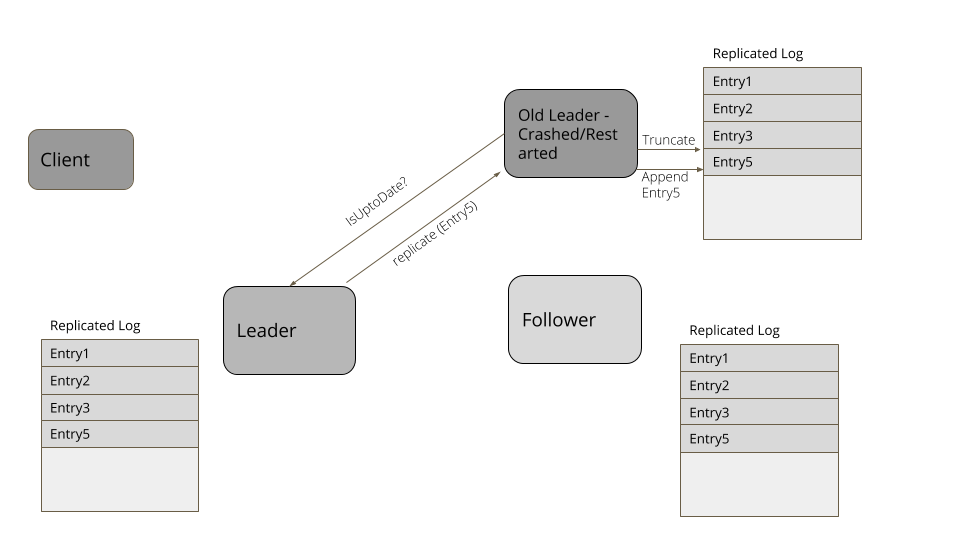

一台服务器在崩溃/重启之后,重新加入集群,日志中总有可能出现一些冲突的条目。因此,每当有一台服务器加入集群时,它都会检查集群的领导者,了解日志中哪些条目可能是冲突的。然后,它会做一次日志截断,以便与领导者的条目相匹配,然后用随后的条目更新日志,以确保它的日志与集群的节点相匹配。

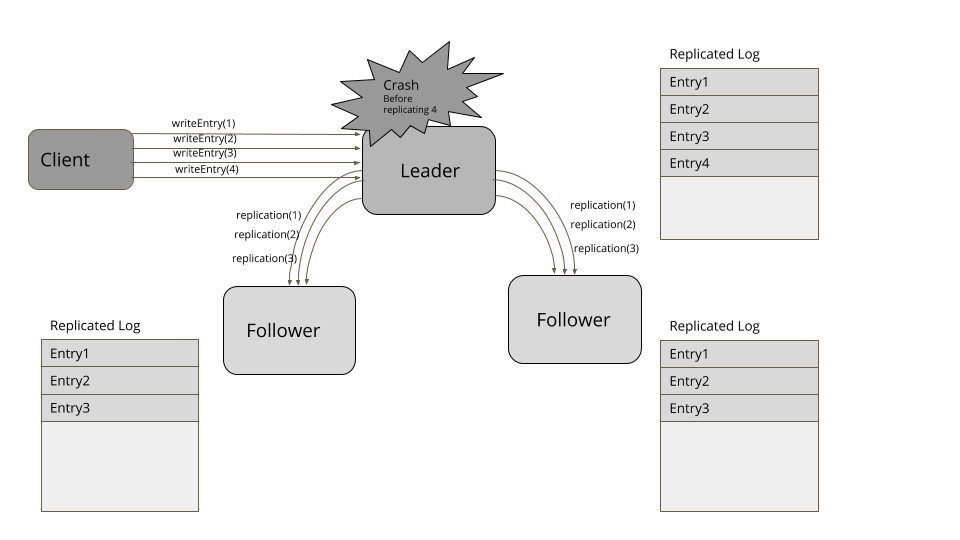

考虑下面这个例子。客户端发送请求在日志中添加四个条目。领导者成功地复制了三个条目,但在日志中添加了第四项后,失败了。一个新的追随者被选为新的领导者,从客户端接收了更多的项。当失效的领导者再次加入集群时,它的第四项就冲突了。因此,它要把自己的日志截断至第三项,然后,添加第五项,以便于集群的其它节点相匹配。

图2:领导者失效

图3:新的领导者

图4:日志截断

暂停之后,重新启动或是重新加入集群,服务器都会先去寻找新的领导者。然后,它会显式地查询当前的高水位标记,将日志截断至高水位标记,然后,从领导者那里获取超过高水位标记的所有条目。类似 RAFT 之类的复制算法有一些方式找出冲突项,比如,查看自己日志里的日志条目,对比请求里的日志条目。如果日志条目拥有相同的索引,但时代时钟(Generation Clock)更低的话,就删除这些条目。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

class ReplicationModule {

private void maybeTruncate(ReplicationRequest replicationRequest) throws IOException {

if (replicationRequest.hasNoEntries() || wal.isEmpty()) {

return;

}

List<WALEntry> entries = replicationRequest.getEntries();

for (WALEntry entry : entries) {

if (wal.getLastLogEntryId() >= entry.getEntryId()) {

if (entry.getGeneration() == wal.readAt(entry.getEntryId()).getGeneration()) {

continue;

}

wal.truncate(entry.getEntryId());

}

}

}

}

要支持日志截断,有一种简单的实现,保存一个日志索引到文件位置的映射。这样,日志就可以按照给定的索引进行截断,如下所示:

1

2

3

4

5

6

7

8

9

class WALSegment {

public void truncate(Long logIndex) throws IOException {

var filePosition = entryOffsets.get(logIndex);

if (filePosition == null)

throw new IllegalArgumentException("No file position available for logIndex=" + logIndex);

fileChannel.truncate(filePosition);

readAll();

}

}

示例

- 所有共识算法都有高水位标记的概念,以便了解应用状态修改的时机,比如,在 RAFT 共识算法中,高水位标记称为“提交索引”。

- 在 Kafka 的复制协议 中,维护着一个单独的索引,称为高水位标记。消费者只能看到高水位标记之前的条目。

- Apache BookKeeper最后添加确认(last add confirmed) 有一个概念,叫‘ ’,它表示在 bookie 的 Quorum 上已经成功复制的条目。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/hybrid-clock.html

使用系统时间戳和逻辑时间戳的组合,这样时间-日期就可以当做版本,用以排序。

2021.6.24

问题

采用有版本的值(Versioned Value)时,如果用 Lamport 时钟当做版本,存储版本时,客户端并不知道实际的日期-时间。对于客户端而言,有时需要能够访问到像 01-01-2020 这样采用日期-时间的版本,而不仅仅是像 1、2、3 这样的整数。

解决方案

混合逻辑时钟(Hybrid Logical Clock) 提供了一种方式,让我们可以拥有一种像简单整数一样能够单调递增的版本,但与实际的日期时间也有关系。在实践中,像 mongodb 或 cockroachdb 这样的数据就采用了混合时钟。

混合逻辑时钟可以这样实现:

1

2

3

4

5

6

7

8

9

10

11

class HybridClock {

public class HybridClock {

private final SystemClock systemClock;

private HybridTimestamp latestTime;

public HybridClock(SystemClock systemClock) {

this.systemClock = systemClock;

this.latestTime = new HybridTimestamp(systemClock.currentTimeMillis(), 0);

}

}

}

它在混合时间戳里维护了最新的时间,这个时间戳使用系统时间和整数计数器共同构建。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

public class HybridTimestamp implements Comparable<HybridTimestamp> {

private final long wallClockTime;

private final int ticks;

public HybridTimestamp(long systemTime, int ticks) {

this.wallClockTime = systemTime;

this.ticks = ticks;

}

public static HybridTimestamp fromSystemTime(long systemTime) {

return new HybridTimestamp(systemTime, -1);

//initializing with -1 so that addTicks resets it to 0

}

public HybridTimestamp max(HybridTimestamp other) {

if (this.getWallClockTime() == other.getWallClockTime()) {

return this.getTicks() > other.getTicks() ? this : other;

}

return this.getWallClockTime() > other.getWallClockTime() ? this : other;

}

public long getWallClockTime() {

return wallClockTime;

}

public HybridTimestamp addTicks(int ticks) {

return new HybridTimestamp(wallClockTime, this.ticks + ticks);

}

public int getTicks() {

return ticks;

}

@Override

public int compareTo(HybridTimestamp other) {

if (this.wallClockTime == other.wallClockTime) {

return Integer.compare(this.ticks, other.ticks);

}

return Long.compare(this.wallClockTime, other.wallClockTime);

}

}

混合时钟的使用方式与Lamport Clock版本完全相同。每个服务器都持有一个混合时钟的实例。

1

2

3

4

5

6

7

8

9

class Server {

HybridClockMVCCStore mvccStore;

HybridClock clock;

public Server(HybridClockMVCCStore mvccStore) {

this.clock = new HybridClock(new SystemClock());

this.mvccStore = mvccStore;

}

}

每次写入一个值,都会关联上一个混合时间戳。诀窍是检查系统时间值是否在往回走,如果是,则递增另一个代表组件逻辑部分的数字,以反映时钟的进展。

1

2

3

4

5

6

7

8

9

10

11

class HybridClock {

public synchronized HybridTimestamp now() {

long currentTimeMillis = systemClock.currentTimeMillis();

if (latestTime.getWallClockTime() >= currentTimeMillis) {

latestTime = latestTime.addTicks(1);

} else {

latestTime = new HybridTimestamp(currentTimeMillis, 0);

}

return latestTime;

}

}

服务器从客户端收到的每个写请求都会带有一个时间戳。接收的服务器会将自己的时间戳与请求的时间戳进行比较,将二者中较高的一个设置为自己的时间戳。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

class Server {

public HybridTimestamp write(String key, String value, HybridTimestamp requestTimestamp) {

//update own clock to reflect causality

HybridTimestamp writeAtTimestamp = clock.tick(requestTimestamp);

mvccStore.put(key, writeAtTimestamp, value);

return writeAtTimestamp;

}

}

class HybridClock {

public synchronized HybridTimestamp tick(HybridTimestamp requestTime) {

long nowMillis = systemClock.currentTimeMillis();

//set ticks to -1, so that, if this is the max, the next addTicks reset it to zero.

HybridTimestamp now = HybridTimestamp.fromSystemTime(nowMillis);

latestTime = max(now, requestTime, latestTime);

latestTime = latestTime.addTicks(1);

return latestTime;

}

private HybridTimestamp max(HybridTimestamp... times) {

HybridTimestamp maxTime = times[0];

for (int i = 1; i < times.length; i++) {

maxTime = maxTime.max(times[i]);

}

return maxTime;

}

}

用于写入值的时间戳会返回给客户端。请求的客户端会更新自己的时间戳,然后,在发起进一步的写入时会带上这个时间戳。

1

2

3

4

5

6

7

8

9

10

class Client {

HybridClock clock = new HybridClock(new SystemClock());

public void write() {

HybridTimestamp server1WrittenAt = server1.write("key1", "value1", clock.now());

clock.tick(server1WrittenAt);

HybridTimestamp server2WrittenAt = server2.write("key2", "value2", clock.now());

assertTrue(server2WrittenAt.compareTo(server1WrittenAt) > 0);

}

}

使用混合时钟进行多版本存储

在键值存储中进行值的存储时,可以采用混合时间戳作为版本。值的存储在有版本的值(Versioned Value)中讨论过。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

class HybridClockReplicatedKVStore {

private Response applySetValueCommand(VersionedSetValueCommand setValueCommand) {

mvccStore.put(setValueCommand.getKey(), setValueCommand.timestamp, setValueCommand.value);

Response response = Response.success(setValueCommand.timestamp);

return response;

}

}

class HybridClockMVCCStore {

ConcurrentSkipListMap<HybridClockKey, String> kv = new ConcurrentSkipListMap<>();

public void put(String key, HybridTimestamp version, String value) {

kv.put(new HybridClockKey(key, version), value);

}

}

class HybridClockKey {

public class HybridClockKey implements Comparable<HybridClockKey> {

private String key;

private HybridTimestamp version;

public HybridClockKey(String key, HybridTimestamp version) {

this.key = key;

this.version = version;

}

public String getKey() {

return key;

}

public HybridTimestamp getVersion() {

return version;

}

@Override

public int compareTo(HybridClockKey o) {

int keyCompare = this.key.compareTo(o.key);

if (keyCompare == 0) {

return this.version.compareTo(o.version);

}

return keyCompare;

}

}

}

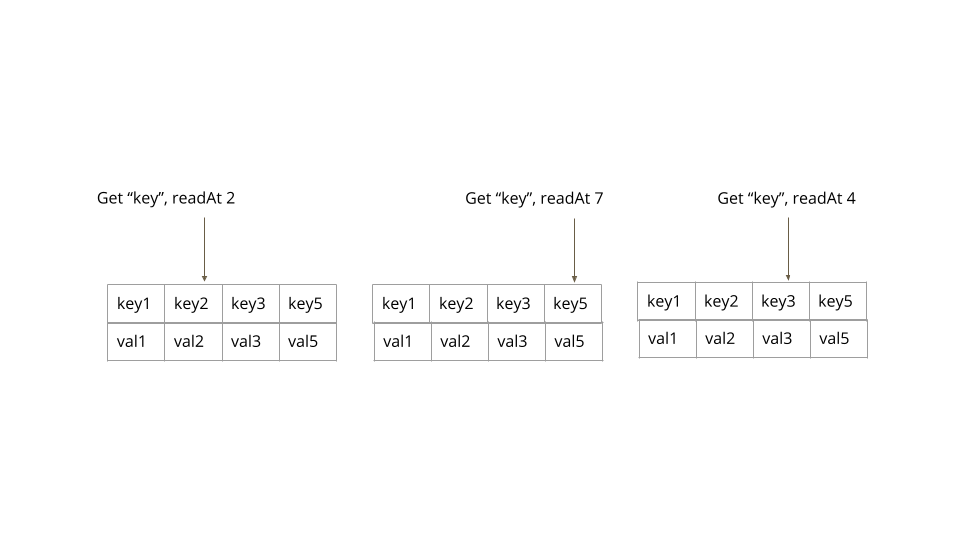

这些值的读取完全是按照有版本的值排序所讨论的那样。使用混合时间戳作为键值后缀,有版本的键值就可以按照自然顺序的方式进行排列。这个实现让我们可以使用可导航的 Map API(navigable map API)获取特定版本对应的值。

1

2

3

4

5

6

7

class HybridClockMVCCStore {

public Optional<String> get(String key, HybridTimestamp atTimestamp) {

Map.Entry<HybridClockKey, String> versionKeys = kv.floorEntry(new HybridClockKey(key, atTimestamp));

getLogger().info("Available version keys " + versionKeys + ". Reading@" + versionKeys);

return (versionKeys == null) ? Optional.empty() : Optional.of(versionKeys.getValue());

}

}

将混合时间戳转换为日期时间

通过将系统时间戳和逻辑计数合并在一起,混合时钟可以转换成实际的时间戳。正如在混合时钟(hybrid-clock)这篇论文中所讨论的,保留系统时间的前 48 位,而低 16 位有逻辑计数器所取代。

1

2

3

4

5

6

7

8

9

10

class HybridTimestamp {

public LocalDateTime toDateTime() {

return LocalDateTime.ofInstant(Instant.ofEpochMilli(epochMillis()), ZoneOffset.UTC);

}

public long epochMillis() {

//Compact timestamp as discussed in https://cse.buffalo.edu/tech-reports/2014-04.pdf.

return (wallClockTime >> 16 << 16) | (ticks << 48 >> 48);

}

}

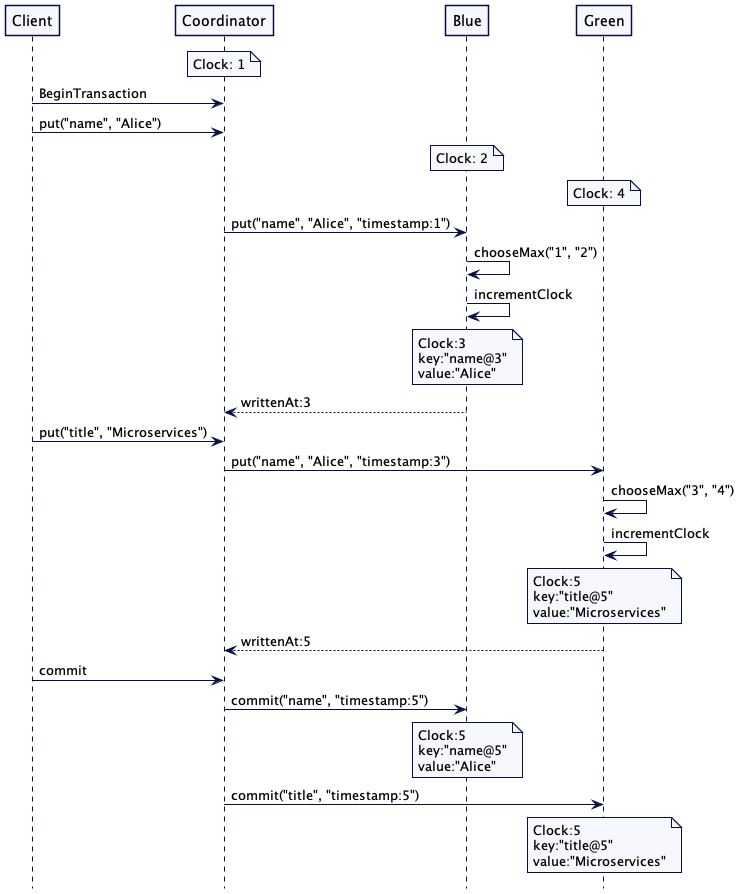

将时间戳赋给分布式事务

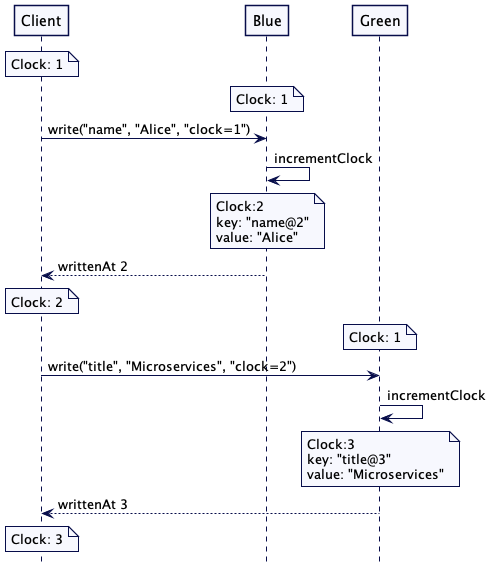

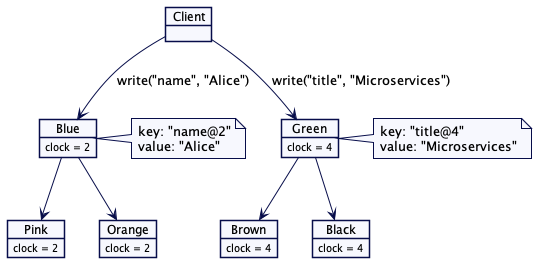

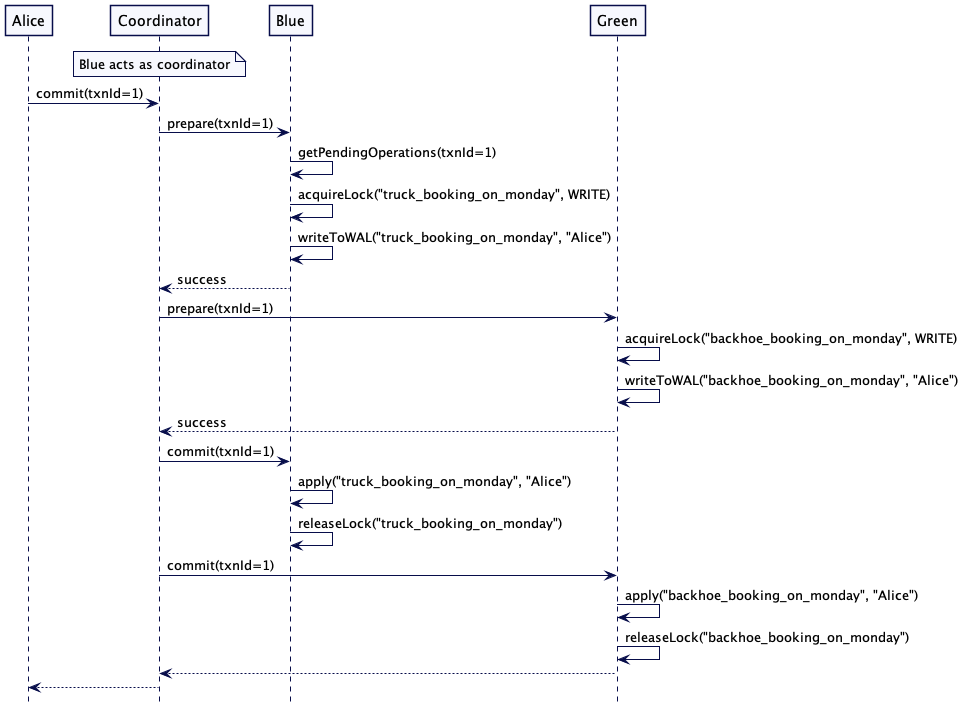

像 mongodb 和 cockroachdb 这样的数据库会使用混合时钟(Hybrid Clock)维持分布式事务的因果性。对于分布式事务而言,需要注意的是,事务提交时,作为事务一部分,所有要存的值在整个服务器集群中都要以相同的时间戳进行存储。请求的服务器或许会在稍后的写请求中知晓了一个更高的时间戳。因此,这个请求服务器就会用它在事务提交时得到的最高的时间戳与所有参与的服务器进行通信。这与标准的两阶段提交(two-phase-commit)协议非常契合。

下面是一个例子,演示了如何在事务提交时确定最高的时间戳。假设有三台服务器。蓝色服务器(Server Blue)存储名字,绿色服务器(Server Green)存储标题。还有一个单独服务器扮演协调者的角色。可以看出,每个服务器都有自己一个不同的本地时钟值。这可以是一个单一的整数,或是混合时钟。扮演协调者的服务器先向蓝色服务器写入它知道的时钟值,也就是 1.但是,蓝色服务器的时钟是 2,所以,它会递增这个值,它会写入一个值,其时间戳是 3。时间戳 3 会返回给协调者。绿色服务器接收到的请求时间戳就是 3,但是,它的时钟是 4。因此,它会选择最高的值,也就是 4.递增它,写入的值时间是 5,再把 5 返回给协调者。当事务提交时,协调者就会采用提交事务中它收到的最高时间戳。在事务中所有更新的值都会以最高的时间戳进行存储。

图 1:在服务器中传播提交的时间戳

一个极简的在事务中处理时间戳的代码是这样的:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

class TransactionCoordinator {

public Transaction beginTransaction() {

return new Transaction(UUID.randomUUID().toString());

}

public void putTransactionally() {

Transaction txn = beginTransaction();

HybridTimestamp coordinatorTime = new HybridTimestamp(1);

HybridTimestamp server1WriteTime

= server1.write("name", "Alice", coordinatorTime, txn);

HybridTimestamp server2WriteTime = server2.write("title", "Microservices", server1WriteTime, txn);

HybridTimestamp commitTimestamp = server1WriteTime.max(server2WriteTime);

commit(txn, commitTimestamp);

}

private void commit(Transaction txn, HybridTimestamp commitTimestamp) {

server1.commitTxn("name", commitTimestamp, txn);

server2.commitTxn("title", commitTimestamp, txn);

}

}

事务实现也可以使用两阶段提交协议中的准备阶段来了解每个参与的服务器所使用的最高时间戳。

示例

mongodb 采用混合时间戳维护其 MVCC 存储中的版本。

cockroachdb 采用混合时间戳维护分布式事务的因果关系。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/idempotent-receiver.html

识别来自客户端的请求是否唯一,以便在客户端重试时,忽略重复的请求。

2021.1.26

问题

客户端给服务器发请求,可能没有得到应答。客户端不可能知道应答是丢失了,还是服务端在处理请求之前就崩溃了。为了确保请求得到处理,客户端唯有重复发送请求。

如果服务器已经处理了请求,然后奔溃了,之后,客户端重试时,服务器端会收到客户端的重复请求。

解决方案

每个客户端都会分配得到一个唯一的 ID,用以对客户端进行识别。发送任何请求之前,客户端需要先向服务器进行注册。

1

2

3

4

5

6

7

8

9

10

11

class ConsistentCoreClient {

private void registerWithLeader() {

RequestOrResponse request

= new RequestOrResponse(RequestId.RegisterClientRequest.getId(), correlationId.incrementAndGet());

//blockingSend will attempt to create a new connection if there is a network error.

RequestOrResponse response = blockingSend(request);

RegisterClientResponse registerClientResponse

= JsonSerDes.deserialize(response.getMessageBodyJson(), RegisterClientResponse.class);

this.clientId = registerClientResponse.getClientId();

}

}

当服务器接收到来自客户端的注册请求,它就给客户端分配一个唯一的 ID,如果服务器是一个一致性内核(Consistent Core),它可以先分配预写日志索引当做客户端标识符。

1

2

3

4

5

6

7

8

9

10

class ReplicatedKVStore {

private Map<Long, Session> clientSessions = new ConcurrentHashMap<>();

private RegisterClientResponse registerClient(WALEntry walEntry) {

Long clientId = walEntry.getEntryId();

//clientId to store client responses.

clientSessions.put(clientId, new Session(clock.nanoTime()));

return new RegisterClientResponse(clientId);

}

}

服务器会创建一个会话(session),以便为注册客户端的请求存储应答。它还会追踪会话的创建时间,这样,会话不起作用时,就可以把它丢弃了,这会在后面详细讨论。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

class Session {

long lastAccessTimestamp;

Queue<Response> clientResponses = new ArrayDeque<>();

public Session(long lastAccessTimestamp) {

this.lastAccessTimestamp = lastAccessTimestamp;

}

public long getLastAccessTimestamp() {

return lastAccessTimestamp;

}

public Optional<Response> getResponse(int requestNumber) {

return clientResponses.stream().filter(r -> requestNumber == r.getRequestNumber()).findFirst();

}

private static final int MAX_SAVED_RESPONSES = 5;

public void addResponse(Response response) {

if (clientResponses.size() == MAX_SAVED_RESPONSES) {

clientResponses.remove();

//remove the oldest request

}

clientResponses.add(response);

}

public void refresh(long nanoTime) {

this.lastAccessTimestamp = nanoTime;

}

}

对一个一致性内核而言,客户端的注册请求也要作为共识算法的一部分进行复制。如此一来,即便既有的领导者失效了,客户端的注册依然是可用的。对于后续的请求,服务器还要存储发送给客户端的应答。

幂等和非幂等请求

注意到一些请求的幂等属性是很重要的。比如说,在一个键值存储中,设置键值和值就天然是幂等的。即便同样的键值和值设置了多次,也不会产生什么问题。另一方面,创建租约(Lease)却并不幂等。如果租约已经创建,再次尝试创建租约 的请求就会失败。这就是问题了。考虑一下这样一个场景。一个客户端发送请求创建租约,服务器成功地创建了租约,然后,崩溃了,或者是,应答发给客户端之前连接断开了。客户端会重新创建连接,重新尝试创建租约;因为服务端已经有了一个指定名称的租约,所以,它会返回错误。因此,客户端就会认为没有这个租约。显然,这并不是我们预期的行为。有了幂等接收者,客户端会用同样的请求号发送租约请求。因为表示“请求已经处理过”的应答已经存在服务器上了,这个应答就可以直接返回。这样一来,如果是客户端在连接断开之前已经成功创建了租约,后续重试相同的请求时,它会得到应有的应答。

对于收到的每个非幂等请求(参见边栏),服务端成功执行之后,都会将应答存在客户端会话中。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

class ReplicatedKVStore {

private Response applyRegisterLeaseCommand(WALEntry walEntry, RegisterLeaseCommand command) {

logger.info("Creating lease with id " + command.getName() + "with timeout " + command.getTimeout() + " on server " + getServer().getServerId());

try {

leaseTracker.addLease(command.getName(), command.getTimeout());

Response success = Response.success(walEntry.getEntryId());

if (command.hasClientId()) {

Session session = clientSessions.get(command.getClientId());

session.addResponse(success.withRequestNumber(command.getRequestNumber()));

}

return success;

} catch (DuplicateLeaseException e) {

return Response.error(1, e.getMessage(), walEntry.getEntryId());

}

}

}

客户端发送给服务器的每个请求里都包含客户端的标识符。客户端还保持了一个计数器,每个发送给服务器的请求都会分配到一个请求号。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

class ConsistentCoreClient {

int nextRequestNumber = 1;

public void registerLease(String name, long ttl) {

RegisterLeaseRequest registerLeaseRequest

= new RegisterLeaseRequest(clientId, nextRequestNumber, name, ttl);

nextRequestNumber++;

//increment request number for next request.

var serializedRequest = serialize(registerLeaseRequest);

logger.info("Sending RegisterLeaseRequest for " + name);

blockingSendWithRetries(serializedRequest);

}

private static final int MAX_RETRIES = 3;

private RequestOrResponse blockingSendWithRetries(RequestOrResponse request) {

for (int i = 0; i <= MAX_RETRIES; i++) {

try {

//blockingSend will attempt to create a new connection is there is no connection.

return blockingSend(request);

} catch (NetworkException e) {

resetConnectionToLeader();

logger.error("Failed sending request " + request + ". Try " + i, e);

}

}

throw new NetworkException("Timed out after " + MAX_RETRIES + " retries");

}

}

服务器收到请求时,它会先检查来自同一个客户端给定的请求号是否已经处理过了。如果找到已保存的应答,它就会把相同的应答返回给客户端,而无需重新处理请求。

1

2

3

4

5

6

7

8

9

10

11

12

13

class ReplicatedKVStore {

private Response applyWalEntry(WALEntry walEntry) {

Command command = deserialize(walEntry);

if (command.hasClientId()) {

Session session = clientSessions.get(command.getClientId());

Optional<Response> savedResponse = session.getResponse(command.getRequestNumber());

if (savedResponse.isPresent()) {

return savedResponse.get();

}

//else continue and execute this command.

}

}

}

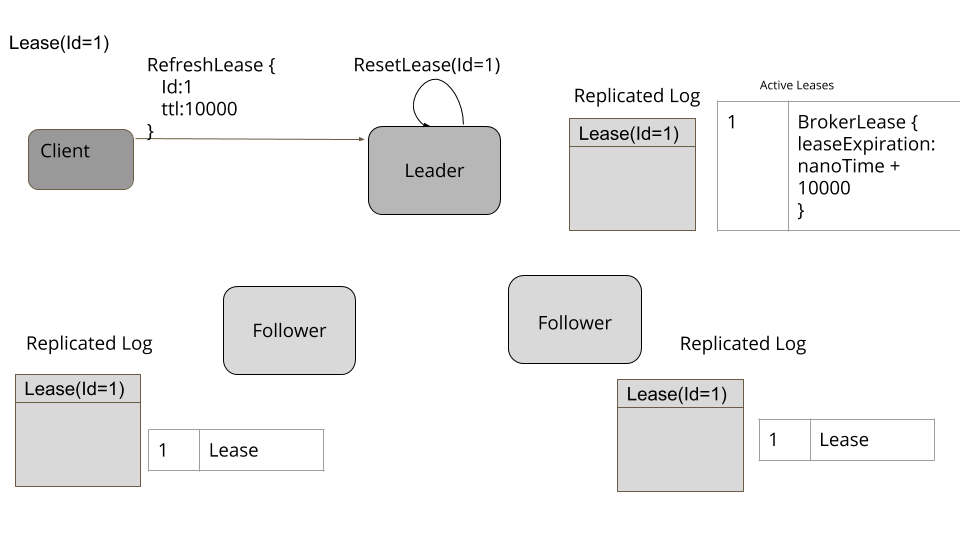

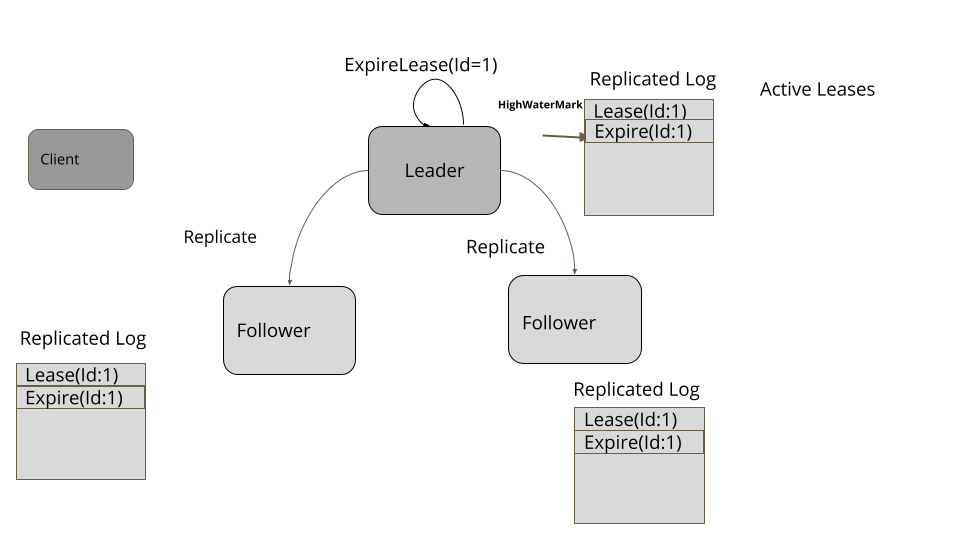

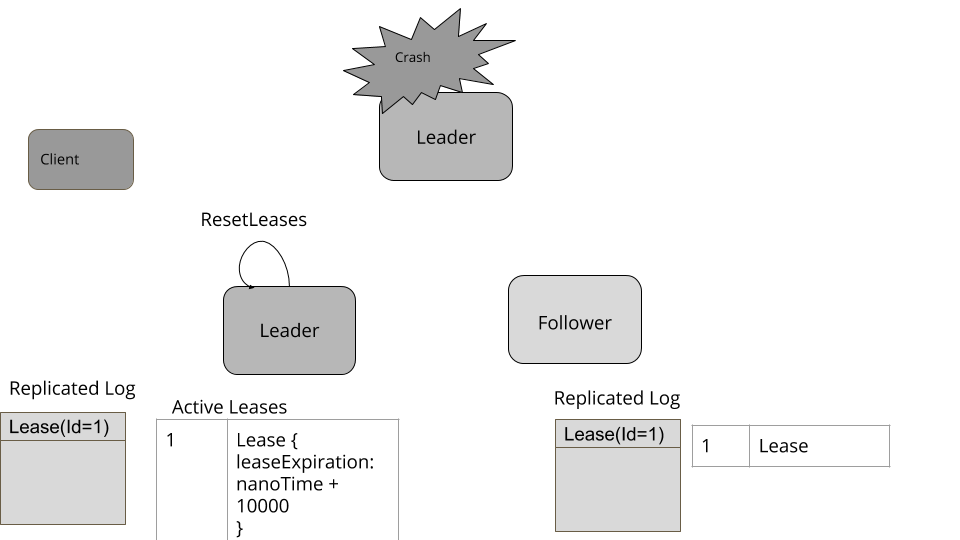

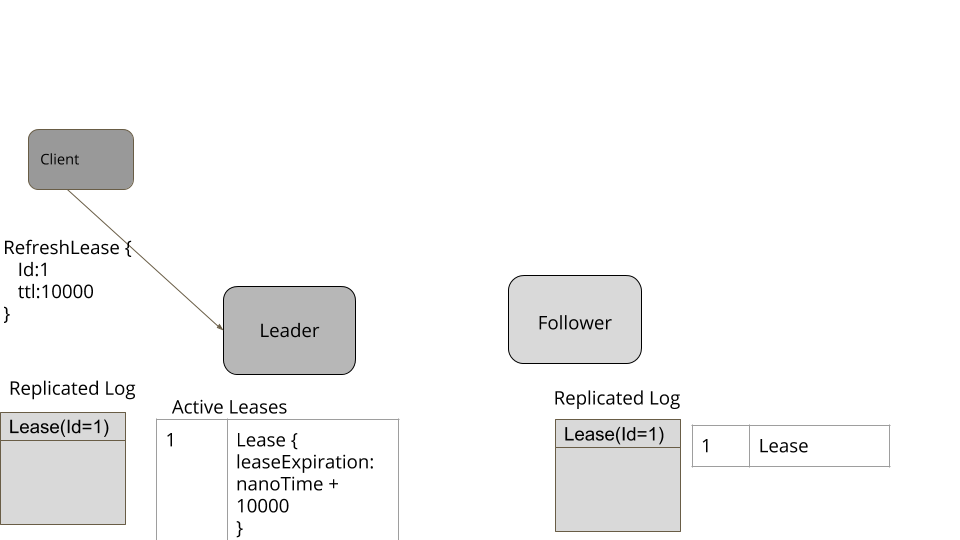

已保存的客户端请求过期处理

按客户端存储的请求不可能是永久保存的。有几种方式可以对请求进行过期处理。在 Raft 的参考实现中,客户端会保存一个单独的号码,以便记录成功收到应答的请求号。这个号码稍后会随着每个请求发送给服务器。这样,对于请求号小于这个号码的请求,服务器就可以安全地将其丢弃了。

如果客户端能够保证只在接收到上一个请求的应答之后,再发起下一个请求,那么,服务器端一旦接收到来自这个客户端的请求,就可以放心地删除之前所有的请求。使用请求管道(Request Pipeline)还会有个问题,可能有在途(in-flight)请求存在,也就是客户端没有收到应答。如果服务器端知道客户端能够接受的在途请求的最大数量,它就可以保留那么多的应答,删除其它的应答。比如说,kafka 的 producer 能够接受的最大在途请求数量是 5 个,因此,它最多保存 5 个之前的请求。

1

2

3

4

5

6

7

8

9

10

11

class Session {

private static final int MAX_SAVED_RESPONSES = 5;

public void addResponse(Response response) {

if (clientResponses.size() == MAX_SAVED_RESPONSES) {

clientResponses.remove();

//remove the oldest request

}

clientResponses.add(response);

}

}

删除已注册的客户端

客户端的会话也不会在服务器上永久保存。一个服务器会对其存储的客户端会话有一个最大保活时间。客户端周期性地发送心跳(HeartBeat)。如果在保活时间内没有收到心跳,服务器上客户端的状态就会被删除掉。

服务器会启动一个定时任务,周期性地检查是否有过期会话,删除已过期的会话。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

class ReplicatedKVStore {

private long heartBeatIntervalMs = TimeUnit.SECONDS.toMillis(10);

private long sessionTimeoutNanos = TimeUnit.MINUTES.toNanos(5);

private void startSessionCheckerTask() {

scheduledTask = executor.scheduleWithFixedDelay(() -> {

removeExpiredSession();

}, heartBeatIntervalMs, heartBeatIntervalMs, TimeUnit.MILLISECONDS);

}

private void removeExpiredSession() {

long now = System.nanoTime();

for (Long clientId : clientSessions.keySet()) {

Session session = clientSessions.get(clientId);

long elapsedNanosSinceLastAccess = now - session.getLastAccessTimestamp();

if (elapsedNanosSinceLastAccess > sessionTimeoutNanos) {

clientSessions.remove(clientId);

}

}

}

}

示例

Raft 有一个实现了幂等性的参考实现,提供了线性一致性的行为。

Kafka 有一个幂等 Producer,允许客户端重试请求,忽略重复的请求。

ZooKeeper 有 Session 的概念,还有 zxid,用于客户端恢复。HBase 有一个 hbase-recoverable-zookeeper 的封装,它实现了遵循 zookeeper-error-handling 指导的幂等的行为。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/lamport-clock.html

使用逻辑时间戳作为一个值的版本,以便支持跨服务器的值排序。

2021.6.23

问题

当值要在多个服务器上进行存储时,需要有一种方式知道一个值要在另外一个值之前存储。在这种情况下,不能使用系统时间戳,因为时钟不是单调的,两个服务器的时钟时间不应该进行比较。

表示一天中时间的系统时间戳,一般来说是通过晶体振荡器建造的时钟机械测量的。这种机制有一个已知问题,根据晶体震荡的快慢,它可能会偏离一天实际的时间。为了解决这个问题,计算机通常会使用像 NTP 这样的服务,将计算机时钟与互联网上众所周知的时间源进行同步。正因为如此,在一个给定的服务器上连续读取两次系统时间,可能会出现时间倒退的现象。

由于服务器之间的时钟漂移没有上限,比较两个不同的服务器的时间戳是不可能的。

解决方案

Lamport 时钟维护着一个单独的数字表示时间戳,如下所示:

1

2

3

4

5

6

7

8

9

class LamportClock

class LamportClock {

int latestTime;

public LamportClock(int timestamp) {

latestTime = timestamp;

}

}

每个集群节点都维护着一个 Lamport 时钟的实例。

1

2

3

4

5

6

7

8

9

class Server {

MVCCStore mvccStore;

LamportClock clock;

public Server(MVCCStore mvccStore) {

this.clock = new LamportClock(1);

this.mvccStore = mvccStore;

}

}

服务器每当进行任何写操作时,它都应该使用tick()方法让 Lamport 时钟前进。

1

2

3

4

5

6

7

class LamportClock {

public int tick(int requestTime) {

latestTime = Integer.max(latestTime, requestTime);

latestTime++;

return latestTime;

}

}

如此一来,服务器可以确保写操作的顺序是在这个请求之后,以及客户端发起请求时服务器端已经执行的任何其他动作之后。服务器会返回一个时间戳,用于将值写回给客户端。稍后,请求的客户端会使用这个时间戳向其它的服务器发起进一步的写操作。如此一来,请求的因果链就得到了维持。

因果性、时间和 Happens-Before

在一个系统中,当一个事件 A 发生在事件 B 之前,这其中可能存在因果关系。因果关系意味着,在导致 B 发生的原因中,A 可能扮演了一些角色。这种“A 发生在 B 之前(A happens before B)”的关系是通过在每个事件上附加时间戳达成的。如果 A 发生在 B 之前,附加在 A 的时间戳就会小于附加在 B 上的时间戳。但是,因为我们无法依赖于系统时间,我们需要一些方式确保这种“依赖于附加在事件上的时间戳”的 Happens-Before 关系得到维系。Leslie Lamport 在其开创性论文《时间、时钟和事件排序(Time, Clocks and Ordering Of Events)》中提出了一个解决方案,使用逻辑时间戳来跟踪 Happens-Before 的关系。因此,这种使用逻辑时间错追踪因果性的技术就被称为 Lamport 时间戳。

值得注意的是,在数据库中,事件是关于存储数据的。因此,Lamport 时间戳会附加到存储的值上。这非常符合有版本的存储机制,这一点我们在有版本的值(Versioned Value)中讨论过。

一个样例键值存储

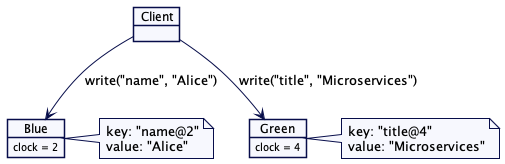

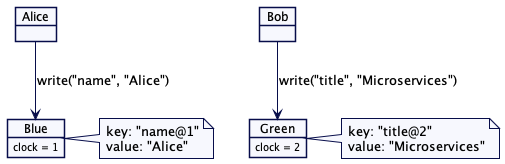

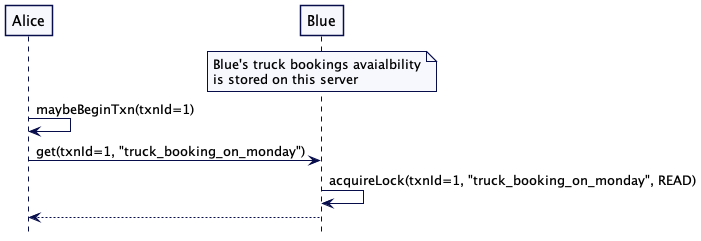

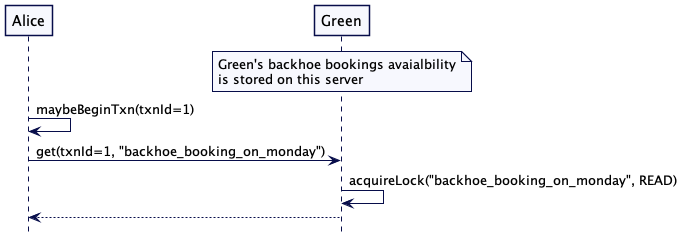

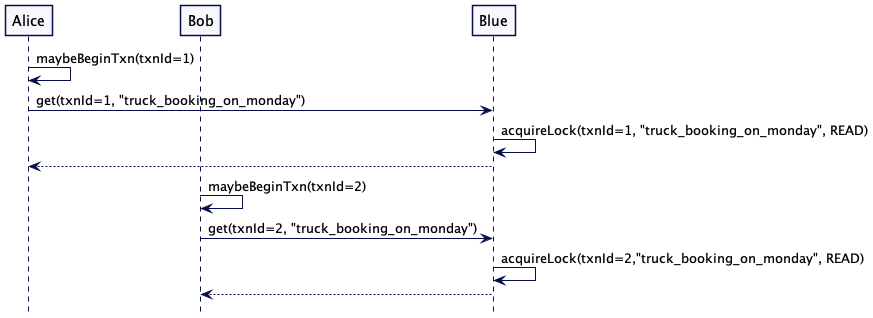

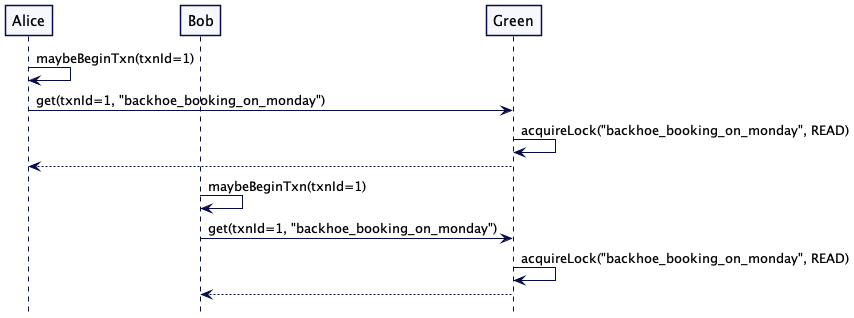

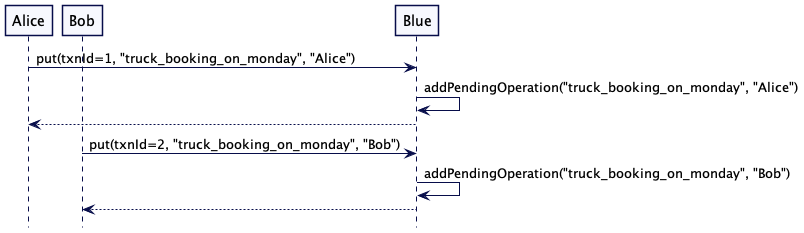

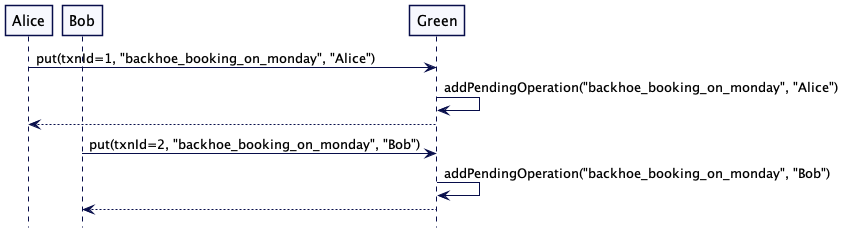

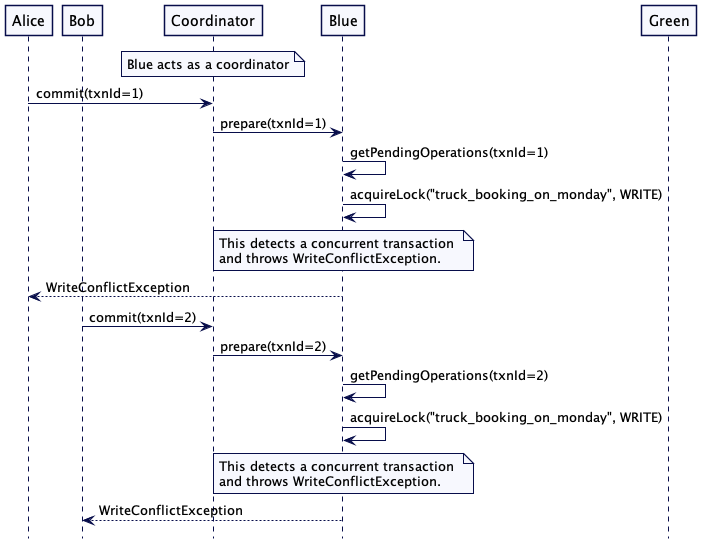

考虑一个有多台服务器节点的简单键值存储的例子。它包含两台服务器,蓝色(Blue)和绿色(Green)。每台服务器负责存储一组特定的键值。这是一个典型的场景,数据划分到一组服务器上。值存储为有版本的值(Versioned Value),其版本号为 Lamport 时间戳。

图1:两台服务器,各自负责特定的键值

接收服务器会比较并更新自己的时间戳,然后,用它写入一个有版本的键值和值。

1

2

3

4

5

6

7

8

class Server {

public int write(String key, String value, int requestTimestamp) {

//update own clock to reflect causality

int writeAtTimestamp = clock.tick(requestTimestamp);

mvccStore.put(new VersionedKey(key, writeAtTimestamp), value);

return writeAtTimestamp;

}

}

用于写入值的时间戳会返回给客户端。通过更新自己的时间戳,客户端会跟踪最大的时间戳。它在发出进一步写入请求时会使用这个时间戳。

1

2

3

4

5

6

7

8

9

10

11

class Client {

LamportClock clock = new LamportClock(1);

public void write() {

int server1WrittenAt = server1.write("name", "Alice", clock.getLatestTime());

clock.updateTo(server1WrittenAt);

int server2WrittenAt = server2.write("title", "Microservices", clock.getLatestTime());

clock.updateTo(server2WrittenAt);

assertTrue(server2WrittenAt > server1WrittenAt);

}

}

请求序列看起来是下面这样:

图2:两台服务器,各自负责特定的键值

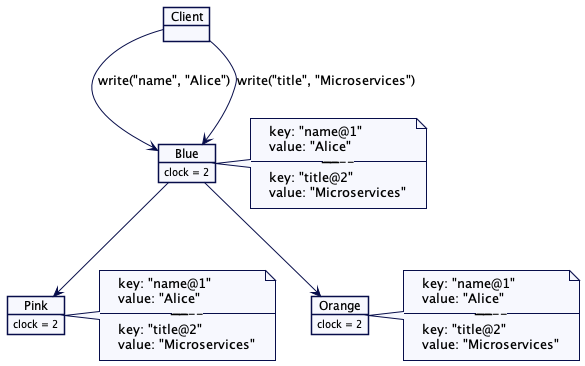

在领导者和追随者(Leader and Followers)组中,甚至可以用同样的技术在客户端和领导者之间的通信,每组负责一组特定的键值。客户端向该组的领导者发送请求,如上所述。Lamport 时钟的实例由该组的领导者维护,其更新方式与上一节讨论的完全相同。

图3:不同的领导者追随者组存储不同的键值

部分有序

使用 Lamport 时钟存储的值只能是部分有序的。如果两个客户端在两台单独的服务器上存储值,时间戳的值是不能用于跨服务器进行值排序的。在下面这个例子里,Bob 在绿色服务器上存储的标题,其时间戳是 2。但是,这并不能决定 Bob 存储的标题是在 Alice 在蓝色服务器存储名字之前还是之后。

图4:部分有序

单一服务器/领导者更新值

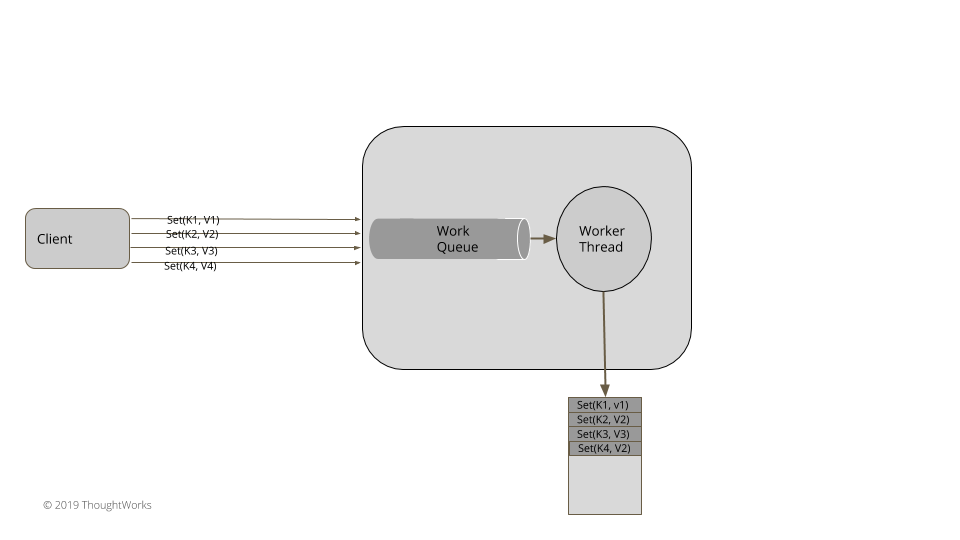

对一个领导者追随者服务器组而言,领导者总是负责存储值,其基本实现已经在有版本的值(Versioned Value)中讨论过,它足以维持所需的因果性。

图 5:单一领导者追随者组进行键值存储

在这种情况下,键值存储会保持一个整数的版本计数器。每次从预写日志中应用了写入命令,版本计数器就要递增。然后,用递增过的版本计数器构建一个新的键值。只有领导者负责递增版本计数器,追随者使用相同的版本号。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

class ReplicatedKVStore {

int version = 0;

MVCCStore mvccStore = new MVCCStore();

@Override

public CompletableFuture<Response> put(String key, String value) {

return server.propose(new SetValueCommand(key, value));

}

private Response applySetValueCommand(SetValueCommand setValueCommand) {

getLogger().info("Setting key value " + setValueCommand);

version = version + 1;

mvccStore.put(new VersionedKey(setValueCommand.getKey(), version), setValueCommand.getValue());

Response response = Response.success(version);

return response;

}

}

示例

像 mongodb 和 cockroachdb 采用了 Lamport 时钟的变体实现了 mvcc 存储。

世代时钟(Generation Clock)是 Lamport 时钟的一个例子。

原文

https://martinfowler.com/articles/patterns-of-distributed-systems/leader-follower.html

有一台服务器协调一组服务器间的复制。

2020.8.6

问题

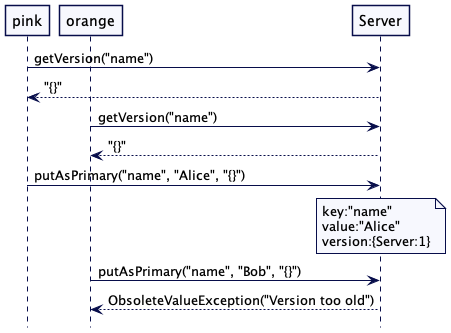

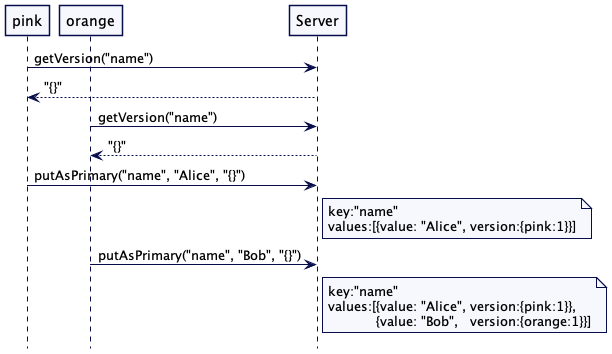

对于一个管理数据的系统而言,为了在系统内实现容错,需要将数据复制到多台服务器上。

有一点也很重要,就是给客户提供一些一致性的保证。当数据在多个服务器上更新时,需要决定何时让客户端看到这些数据。只有写读的 Quorum 是不够的,因为一些失效的场景会导致客户端看到不一致的数据。单个的服务器并不知道 Quorum 上其它服务器的数据状态,只有数据是从多台服务器上读取时,才能解决不一致的问题。在某些情况下,这还不够。发送给客户端的数据需要有更强的保证。

解决方案

在集群里选出一台服务器成为领导者。领导者负责根据整个集群的行为作出决策,并将决策传给其它所有的服务器。

每台服务器在启动时都会寻找一个既有的领导者。如果没有找到,它会触发领导者选举。只有在领导者选举成功之后,服务器才会接受请求。只有领导者才会处理客户端的请求。如果一个请求发送到一个追随者服务器,追随者会将其转发给领导者服务器。

领导者选举

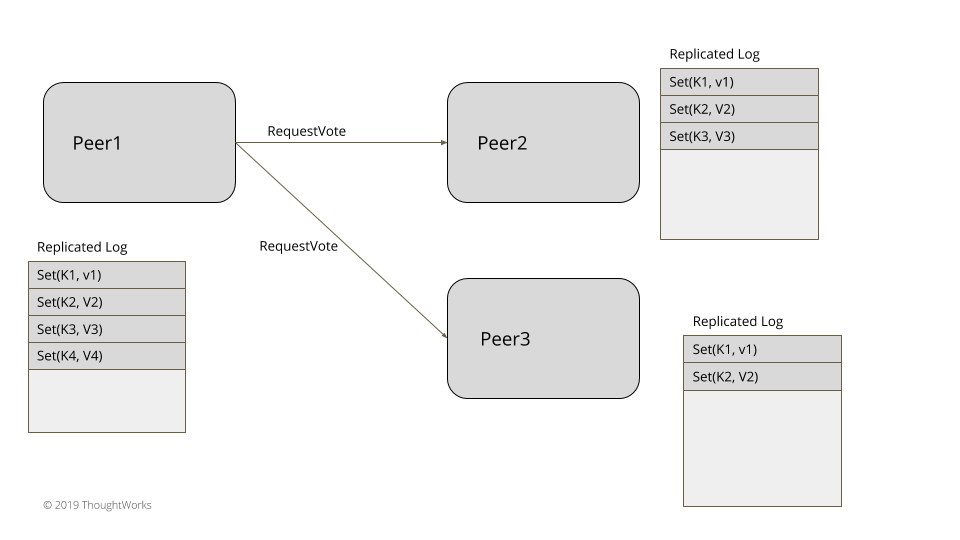

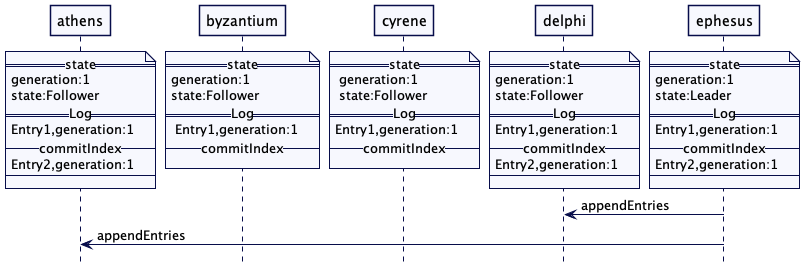

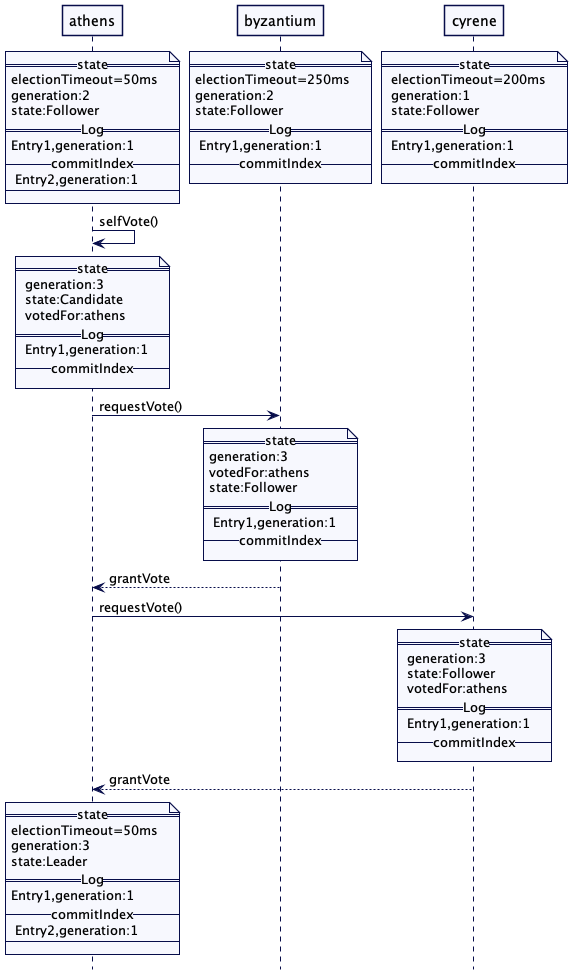

图1:选举

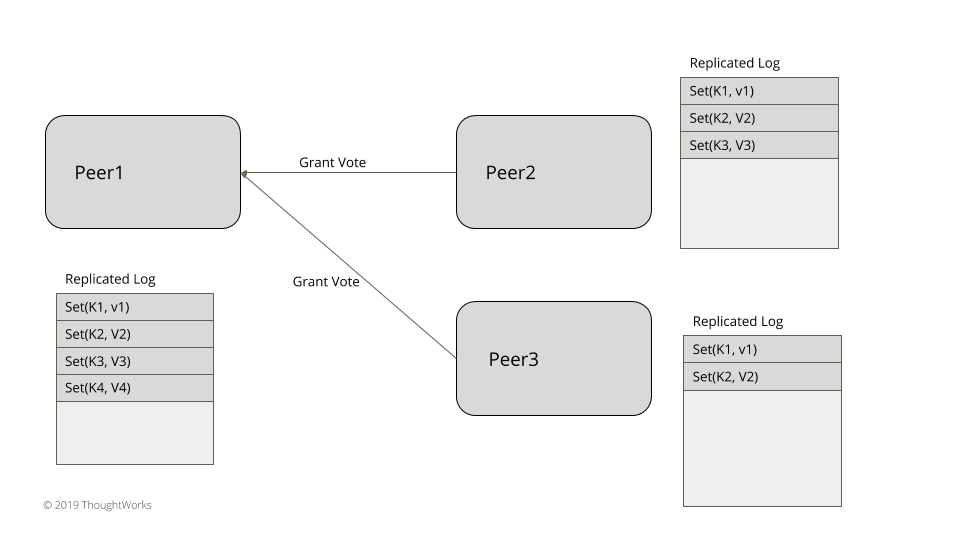

图2:投票

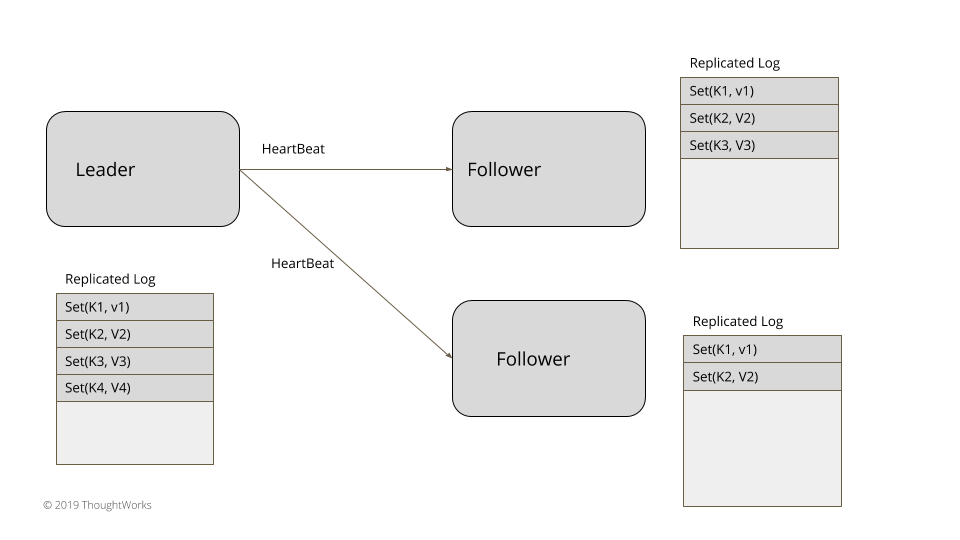

图3:领导者心跳

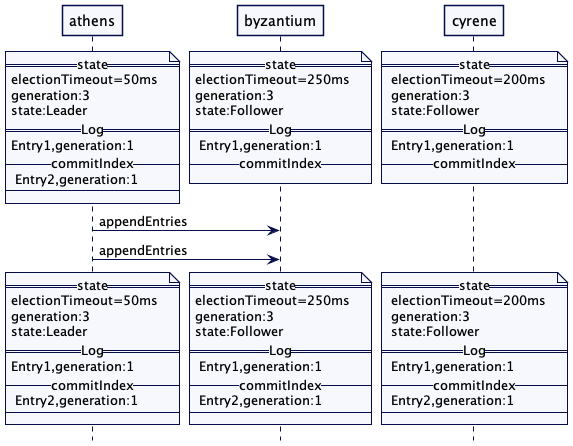

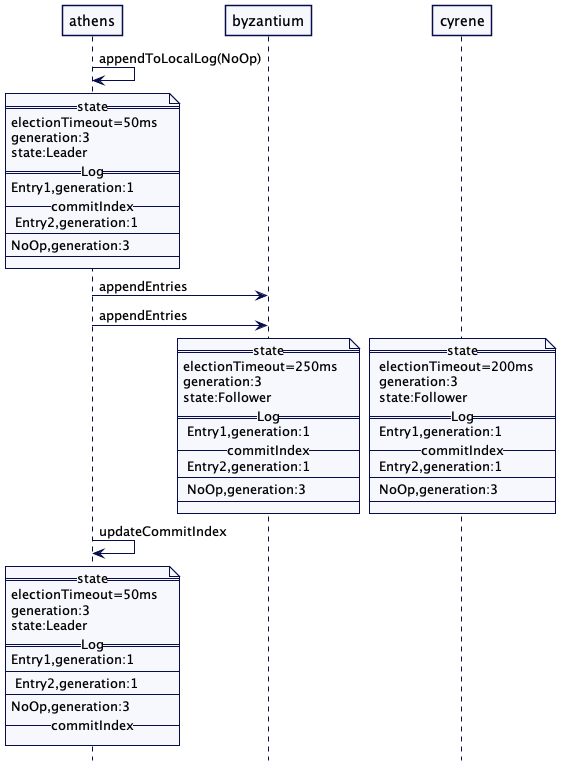

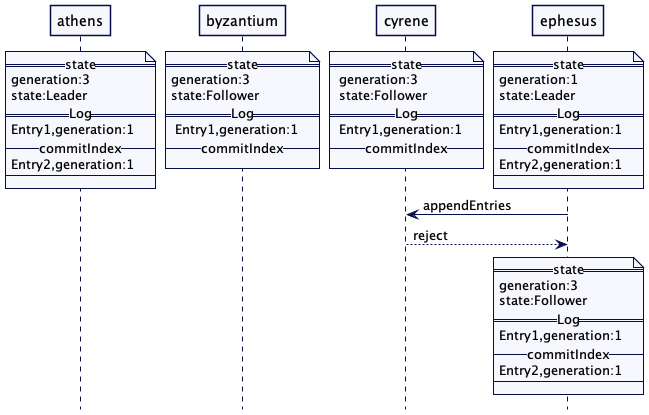

对于三五个节点的小集群,比如在实现共识的系统中,领导者选举可以在数据集群内部实现,不依赖于任何外部系统。领袖选举发生在服务器启动时。每台服务器在启动时都会启动领导者选举,尝试选出一个领导者。在选出一个领导者之前,系统不会接收客户端的任何请求。正如在世代时钟(Generation Clock)模式中所阐释的那样,每次领导者选举都需要更新世代号。服务器总是处于三种状态之一:领导者、追随者或是寻找领导者(或候选者)。

1

public enum ServerRole { LOOKING_FOR_LEADER, FOLLOWING, LEADING;}

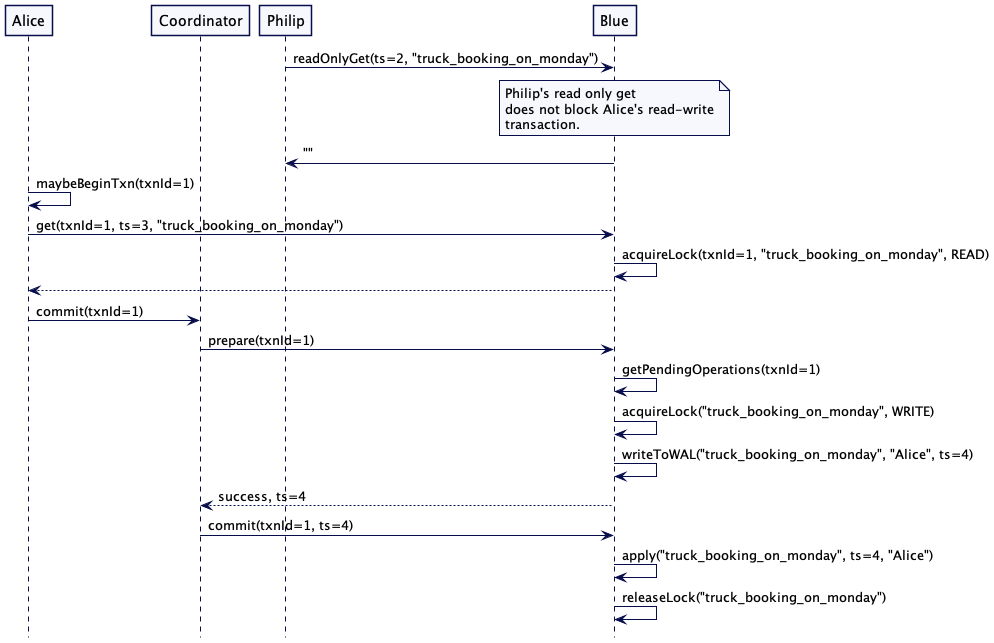

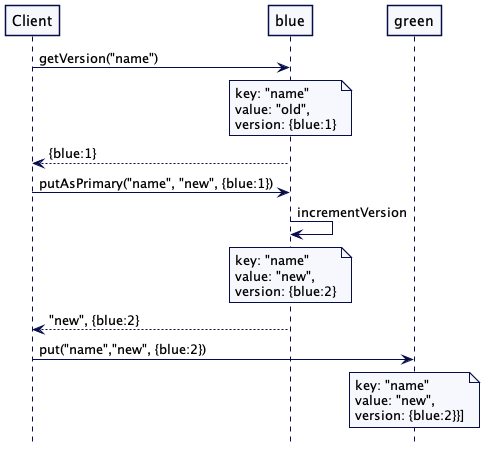

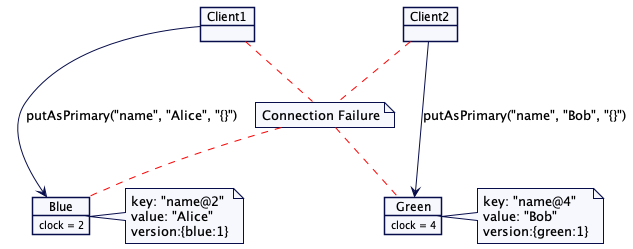

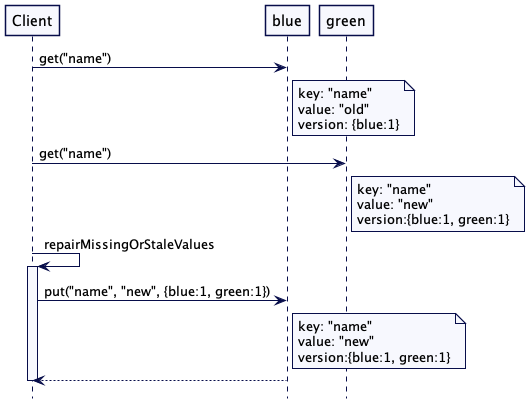

心跳(HeartBeat)机制用以检测既有的领导者是否失效,以便启动新的领导者选举。